Google Cloud Next Tokyo'24 現地参加レポート

- Authors

- Name

- ごとれん

- X

- @ren510dev

目次

- 目次

- はじめに

- 基調講演 - Day 1

- Google Cloud 平手氏の挨拶

- Google DeepMind と Gemini の革新性

- Vertex AI

- Gemini 以外のモデル

- カスタマーエージェント

- Gemini for Google Workspace

- ビジネス変革への取り組み

- AI Hackathon

- 基調講演 - Day 1 所感

- 基調講演 - Day 2

- Google Cloud 渕野氏の挨拶

- コンテクスチュアル広告の事例

- クリエイティブエージェント

- データエージェント

- コードエージェント

- データベースの最新情報:Spanner と Bigtable

- セキュリティと生成 AI

- デジタルワークプレイス環境のレジリエンス強化

- 最後に

- 基調講演 - Day 2 所感

- セッション

- 【Day 1】Ubie:Google Cloud モニタリングベストプラクティス

- 【Day 2】リクルート:FinOps 推進事例

- 展示ブース

- BigQuery Racing Insights

- まとめ

はじめに

8 月 1 - 2 日(2 Days)パシフィコ横浜にて開催された Google Cloud Next Tokyo'24 に現地参加してきました。 基調講演では主に生成 AI の最新動向や将来性について、実際の活用事例や今後の展望、使用していく上での課題や解決策に関する話題がメインでした。

今回のブログでは、基調講演をはじめ、いくつか気になったセッションに関してまとめようと思います。

基調講演 - Day 1

- Google Cloud 平手 智行 氏

- Google DeepMind セシュ アジャラプ 氏

- Google アーワン メナード 氏

- Google Cloud クリスティナ ベア 氏

- Google Cloud 諏訪 悠紀 氏

- Google Cloud 白川 遼 氏

- 東日本旅客鉄道株式会社 伊勢 勝巳 氏

- LINE ヤフー株式会社 宮澤 弦 氏

- 星野リゾート 星野 佳路 氏

Google Cloud 平手氏の挨拶

はじめに、Google Cloud 平手 智行 氏から挨拶と、生成 AI の変革、Google Cloud との位置付けに関する話がありました。

生成 AI の活用は「試す」から「使う」へシフト

AI(特に生成 AI)は、企業の生産性向上や経済価値創出に大きく貢献しており、その活用は「試す」段階から「使う」段階へと急速に移行してきている。 「これからのビジネスの現場において AI の活用は加速し、その中心に生成 AI がある。そして、その生成 AI のインフラを提供するのが Google Cloud である」と強調した。

Google は日本を生成 AI の重要拠点とし、日本をデータハブとし、北米やアジアと繋げると発表。 生成 AI の最新機能と性能をフルに発揮するためのインフラ網を整備するべく、日本と北米、アジアを結ぶ 5 本の海底ケーブルの開通プランに加え、約 1,500 億円を投資し、新たに 2 つの海底ケーブルを構築することが計画されているようです。

マルチモーダルモデル Gemini 1.5 Pro

AI の活用が、モデルの活用から生成 AI エージェントの活用へと急激に変化していると強調。 また、ビジネスの現場で、生成 AI は「試す段階から使う段階」へと移行しており、それを担うのが、大容量のコンテキストを持つ マルチモーダルモデル Gemini 1.5 Pro であると語った。

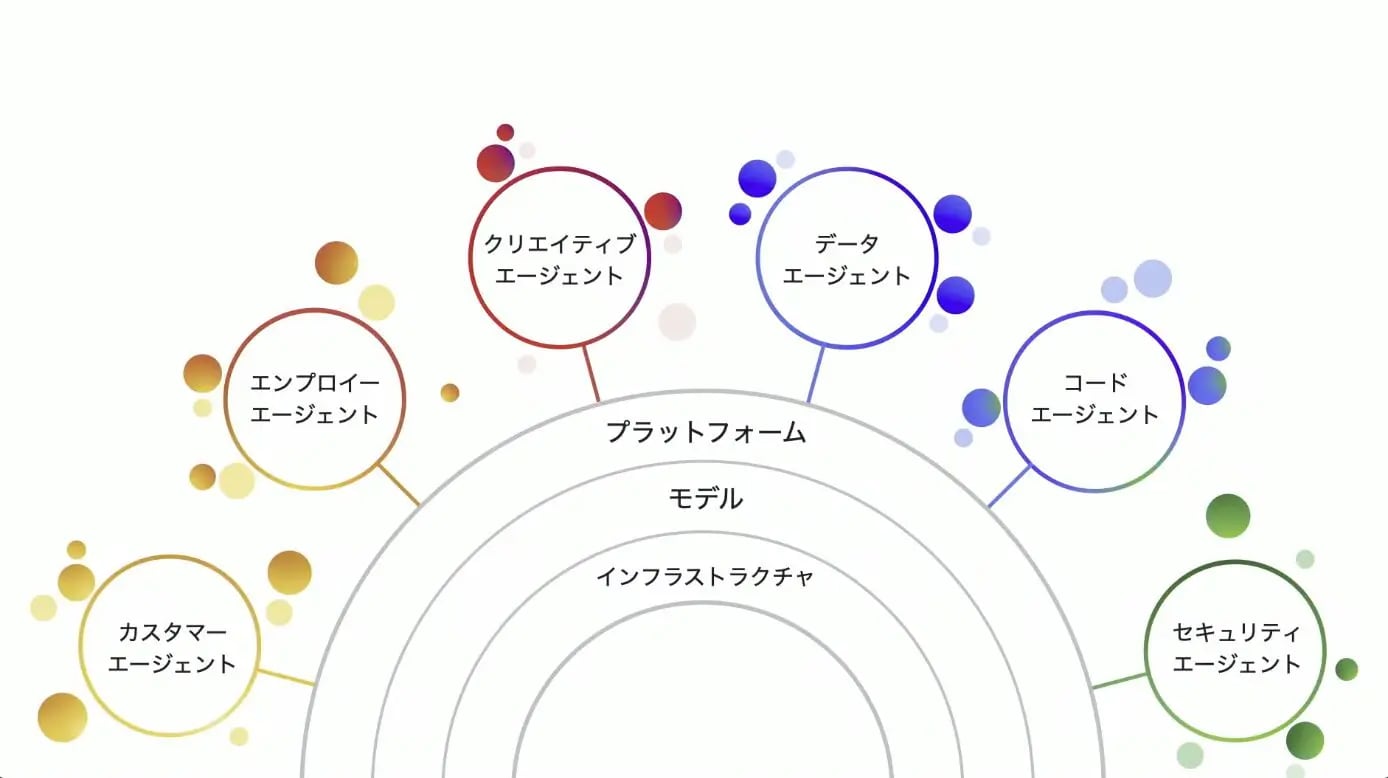

LLM(大規模言語モデル)単体では特定のタスクしか実行できないが、AI エージェントを用いることで業務全体をカバーできるようになる。 その中で、Gemini をはじめとする AI を活用し、ビジネスの現場で信頼して使える AI アプリケーションを開発、運用するためのフルスタックのサービスラインアップを発表。

Google のフルスタックな AI サービス

- AI ハイパーコンピュータ

- AI に最適化されたインフラストラクチャ

- 以下のハードウェアを提供し、AI 構築の時間を短縮 できる

- A3 Mega VMS GA

- NVIDIA GB200 NVL72(2025 年提供開始予定)

- Gemini

- 大規模言語モデル

- Gemini を筆頭に、Claude を含む 150 を超えるモデルを自由に選択可能

- Vertex AI

- レベルを問わない E2E モデル開発

- 生成 AI エージェントの構築運用のための統合プラットフォームを活用可能

- Gemini for Google Cloud

- エラー解析やガイド等、システムの開発運用を行うエンジニア向けのエージェントを使用可能

- Gemini for Google Workspace

- Gmail やスプレッドシートに組み込まれたエージェントを使用可能

- AI エージェント

- 上記のフルスタックサービスを用いることで、独自のエージェント構築やプラットフォームの活用が可能

最新モデルの Gemini 1.5 Pro は、大容量のコンテキスト処理に加え、音声、画像、動画、テキスト、コード等のマルチモーダル機能を備え、約 2 時間分のビデオ、1,000 ページ以上の PDF の書類を一度に取り込むことが可能。

Google DeepMind と Gemini の革新性

Google DeepMind のセシュ アジャラプ 氏は、DeepMind が強化学習を用いて「AlphaGo」や「StarCraft」等の画期的な AI エージェントを生み出したこと、そして 2023 年に Google Brain と合併し、最新の言語モデル Gemini を発表したことを紹介。

また、Gemini が LMSYS CHatbot Arena Leaderboard の日本語カテゴリでナンバーワンになったことについて触れ、DeepMind は、Gemini を誰もが利用できるようにすることで AI の変革の力を共有したいと考えていると述べた。

SynthID による誤情報の除去

Google DeepMind は、SynthID という電子透かし機能を開発し、画像だけでなく、動画やテキストの誤情報を取り除く取り組みもしているようです。

Vertex AI

Google AI ディレクター プロダクト マネージメント アーワン メナード氏より Google Cloud の AI 戦略について、ビジネスユーザ向けの事前構築済み AI アプリケーションと、開発者向けの AI 構築プラットフォーム「Vertex AI」の 2 つの側面から紹介がありました。

ビジネスユーザ向けには、カスタマーエクスペリエンス向上と従業員の生産性向上を目的とした「Customer Experience with Google AI」は、Web サイトでのチャット、バーチャルエージェントとの対話、人間エージェントとのシームレスな連携等を実現するコンタクトセンター向けソリューション。

開発者向けには独自の AI アプリケーションを構築するための包括的なプラットフォームである「Vertex AI」を提供していると述べた。 Vertex AI は、Model Garden、Model Builder、Agent Builder で構成され、企業は 150 以上のモデルから選択し、カスタマイズし、AI エージェントを構築することが可能。

また、企業が AI エージェントを構築するための Agent Builder では、ノーコード、ローコード、フルコードの 3 つのオプションも提供している。

Gemini モデル国内利用の強化

Gemini モデルに関する以下のサービスの発表がありました。

- ML proccessing in Japan

- ユーザ プロンプト、モデルの回答、学習データが日本で保存できたが、さらに機械学習処理も日本で完結できるようになった

- これにより、Gemini に関する処理を全て日本でできるようになる

- (2024 年後半に実装予定)

- Gemini for Google Cloud SLA

- Gemini が SLA の対象になり、信頼性の要件が厳しく規制された業界でも使用可能になる

生成 AI にとって難しい領域だった、厳しい要件にも適用できるようなサービスが登場することで、より多くの業界で生成 AI の活用が期待されます。

Gemini 以外のモデル

- Gemma 2

- Google が提供するオープンモデルの最新版

- 90 億パラメータ、270 億パラメータのモデルが Vertex AI から利用できるようになる

- MaaS:Mobility as a Service

- 以下のモデルが MaaS として、Vertex AI Modelgarden に追加され、セットアップやインフラなしで利用できるようになる

- Llama 3.1

- Mistral

- 以下のモデルが MaaS として、Vertex AI Modelgarden に追加され、セットアップやインフラなしで利用できるようになる

- PLaMo-100B

- 日本語最高クラスの性能で、1000 億パラメータ規模の LLM

- マーケットプレイスから利用できるようになる

コンテキストキャッシング

Gemini 1.5 pro、Gemini 1.5 Flash でコンテキストキャッシングができるようになった。 これによりコンテンツのキャッシュと、新しいプロンプト入力を組み合わせて生成することができるようになり、入力コストを最大で 75% 削減できるようになる。

Grounding on Vertex AI

サードパーティデータセットによるグラウンディング

サードパーティコネクタを使用することで、Google Cloud に保存されてるデータだけでなく、Slack や SharePoint 等をデータソースとすることができるようになる。 サードパーティコネクタで社内の業務効率が劇的に変わる可能性もある。

LINE ヤフーでの生成 AI 活用

LINE ヤフー株式会社 上級執行役員 生成 AI 統括本部長の宮澤 弦氏より Vertex AI を使った開発の話がありました。 生成 AI の活用には情報の正確性が大事であり、ハルシネーション(Hallucination:AI が生成する不正確な情報)を減らす必要があると述べた。

当初は Google 以外の LLM を使っていたが、ハルシネーションが解決できないといった問題があったが、Vertex AI Agent Bulder Search を利用することで、迅速かつ高度なグラウンディングを実現し、Yahoo!フリマでは商品説明文章の自動生成速度を、20 秒から 4 秒 に短縮し、商品の出品完了率を 3% 上昇させたと発表しました。

カスタマーエージェント

カスタマーエージェントは優秀な販売員のように、顧客の話に耳を傾けながら、音声やテキストを通じて顧客をサポートするエージェント。

デモでの実用例の紹介

カスタマーエージェントを活用したデモでは、Gemini のマルチモーダル検索とセマンティック検索を活用したシームレスな EC サイトが披露された。 これにより、顧客のショッピング体験を大きく向上することが期待されます。

Gemini for Google Workspace

Google Workspace(GWS)と Gemini のコラボレーション

Google Cloud のクリスティナ ベア 氏は、Google が 2023 年 3 月、Google Workspace(GWS)に生成 AI を導入して以来、100 万人以上のユーザと数万の企業が Gemini for Workspace を使い始めていると述べました。 TBS、Nittera、LIXIL 等、日本の顧客にもその価値をもたらしている。 サイドパネルの日本語対応は、9 月に Labs と Alpha に入り、その後 GA となる予定。 サイドパネルを使用すると、ユーザは使い慣れた Google Workspace のアプリケーションで Gemini とチャットできる。

Gems でカスタマイズ

Gems は、ユーザ向けにパーソナライズされたプランや計画、指標等を、ユーザの指示に合わせて作成してくれるサービス。

GWS における LLM の活用

LLM の活用によって、Gmail のスパムを 20% 減少させることができ、9 億件ものファイルの識別と分類、機密データの安全を保護している。

サイドパネルのリリース

GWS のどのアプリケーションからでも Gemini とチャットすることができるようになり、GWS のデータを参照できるので個別化されたワークフローを実現できるようになる。

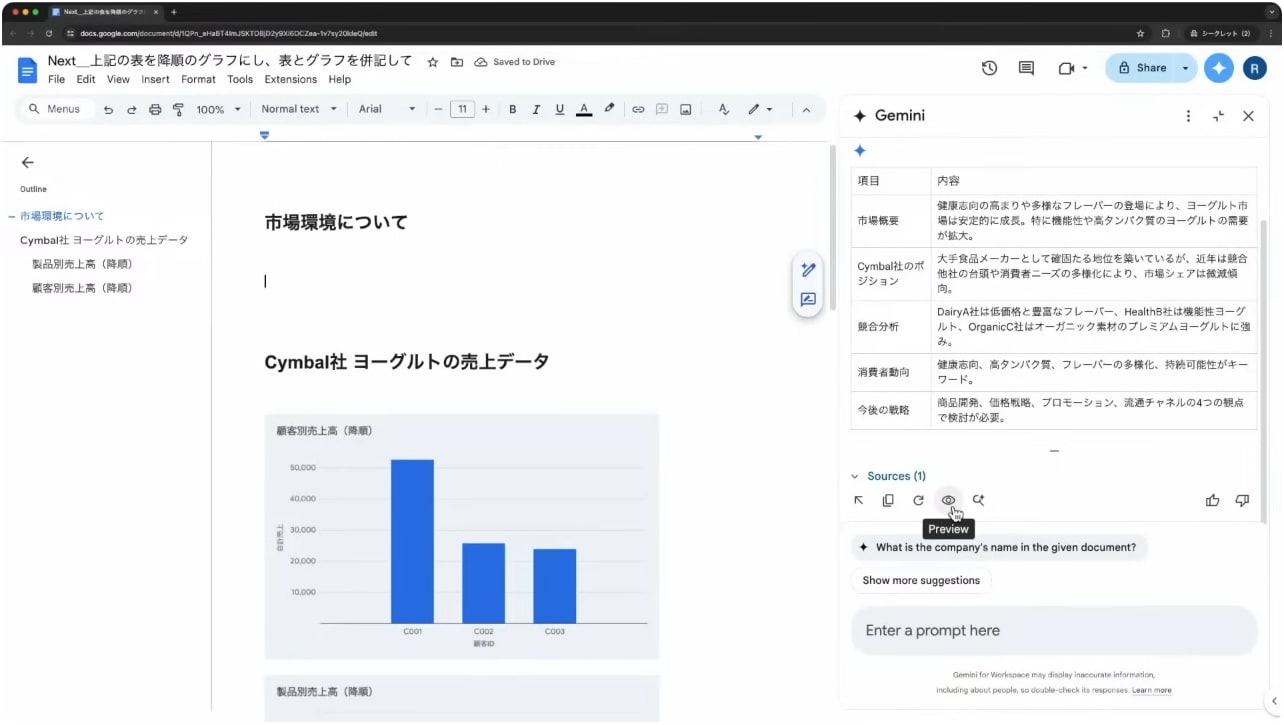

Gemini に業務フローを行わせるデモ

デモでは、業務フローを Gemini を活用して簡単かつ迅速に行う方法が披露された。 Gmail からメールの抽出、GWS 内のファイルの参照、分析、資料の作成、上司や同僚への共有までを高速かつ効率的にできることが期待されます。

数分間の短いデモ時間の中で、Gemini と対話していくだけで全ての業務が完了する様子は圧巻でした。 Gemini によってどんどん業務が効率化していくのを実感しました。

Gemini for Google Workspace の活用

実際に、星野リゾート代表の星野 佳路氏より、Gemini for Google Workspace を導入することによってもたらされるメリットについて、話がありました。 星野リゾートは、生成 AI を観光産業における 4 つ目の大きな変化と捉え、いち早く導入し、従業員の習熟を促進していく方針だと述べました。

生成 AI が観光産業にもたらす 4 つの変革

生成 AI を活用すると以下のようなことが可能になる。

- 言語対応

- その国の言語を使うと顧客により良い体験を提供することができる

- 正確性

- すべての作業に正確性をもたせることができる

- 固定観念からの脱却

- 自分以外の視点を生成 AI から取り入れることができる

- 創造性の刺激

- 生成 AI とブレストすることによって効率化できる

訪日外国人向けチャットアプリ「JR East Travel Concierge」

東日本旅客鉄道の伊勢 勝巳氏は、Google Cloud と連携し、訪日外国人向けチャットアプリ「JR East Travel Concierge」を開発したと述べました。 このアプリケーションは、Gemini 1.5 Pro を活用し、言葉の壁や文化の違い、地方の情報不足といった訪日外国人の旅行計画における課題解決を支援するもので、具体的には、リアルタイムな情報提供、ユーザの好みに基づいた観光スポット提案、最適な旅行プランの自動生成といった機能を提供する。 これにより、訪日外国人は、よりパーソナライズされた旅行体験を得ることができ、地方の魅力発見や旅行中の安心感にも繋がると期待されている。

ビジネス変革への取り組み

最後に、東日本旅客鉄道株式会社 代表取締役副社長 イノベーション戦略本部長 CTO・CDO・CIO の伊勢 勝巳氏より、AI に積極的に取り組み、ビジネス変革へ取り組む方法の話がありました。

ビジネスへの AI 活用

東日本旅客鉄道株式会社は、旅行業界が直面している、言葉、文化の壁、地方の情報不足といった問題に対して、情報提供機能、スポット提案機能、旅程生成機能を搭載したアプリケーションを開発することで対応した。 また、アプリケーションだけでなく、生成 AI を活用した駅の案内サービスの開発等様々な形で AI のビジネス活用に取り組んでいるとのことです。

AI Hackathon

講演の終わりに、Google Cloud が主催する AI Hackathon について発表されました。

基調講演 - Day 1 所感

Google Cloud Next Tokyo'24 Day 1 の基調講演は、生成 AI に関するアップデートを中心に、Google の取り組みや最新ソリューションの紹介、その活用事例に関する話題が豊富でした。 ここ数年でも AI(生成 AI)は急速に発展していて、モデルやソリューションも大きく変わってきています。 AI は試験段階から、本格的に業務フローやサービス、ソリューションに組み込まれるフェーズへと変化しており、確実に実用的なプラットフォームになってきています。

Google がインフラレベルで生成 AI の発展を支援していることや、新たに SLA を制定したことで、ますます導入傾向は右肩上がりになり、活用方法も多様化することが予想されます。

如何に生成 AI を使いこなし、ビジネスパートナーにできるか がカギになるので、今後もしっかり情報のキャッチアップをしていきたいと思います。

基調講演 - Day 2

- Google Cloud ブラッド カルダー 氏

- Google Cloud アンディ ガットマンズ 氏

- Google Cloud 渕野 大輔 氏

- Google Cloud 橋村 抄恵子 氏

- Google Cloud 上野 由美 氏

- Google Cloud 高村 哲貴 氏

- 日本テレビ放送網株式会社 辻 理奈 氏

- ヤマト運輸株式会社 秦野 芳宏 氏

- トヨタ自動車株式会社 後藤 広大 氏

- 株式会社三井住友フィナンシャルグループ 高松 英生 氏

Google Cloud 渕野氏の挨拶

Day 1 に続き、Google Cloud カスタマーエンジニアリング 技術本部長 渕野 大輔氏より挨拶と、生成 AI を活用したアプリケーション開発の市場動向、ハルシネーションに関する課題と向き合い方について話がありました。

また、生成 AI を活用したアプリケーションの開発が市場で進んでいると語り、その中でハルシネーションをどのように減らしていくかが課題となっていると語りました。

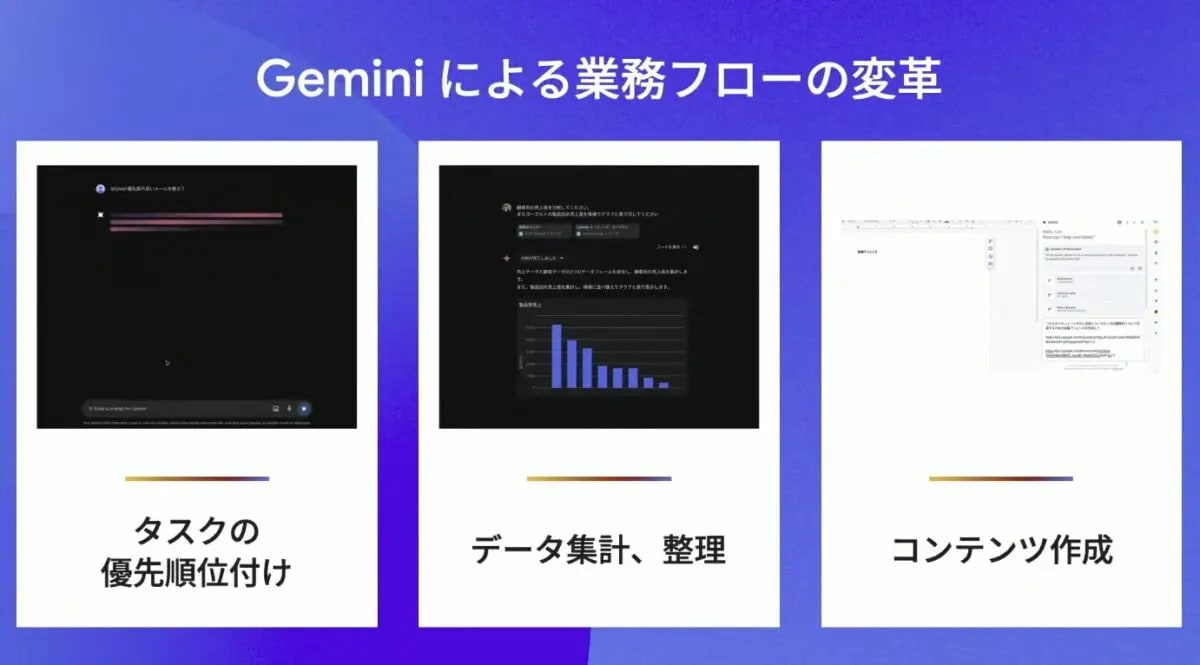

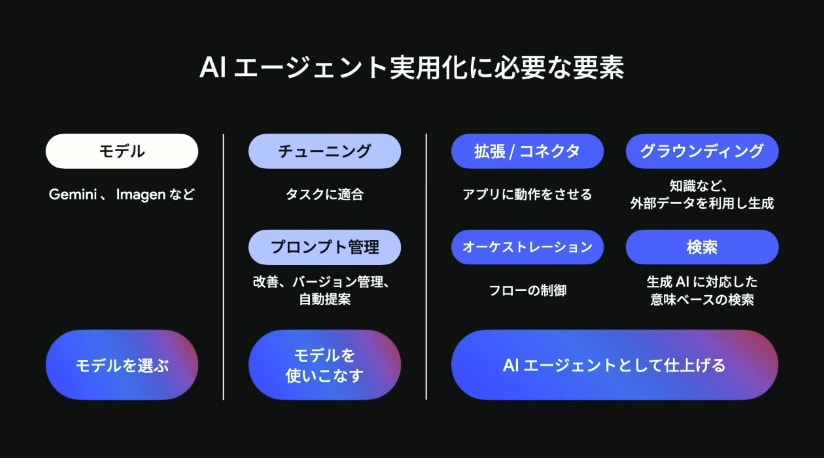

生成 AI は爆発的な普及を遂げている一方で、それらが生むハルシネーションを如何に減らしていくかが課題となっている。 また、ハルシネーションの課題解決のために、AI エージェント が役立つことを強調した。 「生成 AI をどのように開発するか」から「生成 AI で何を開発するかにシフトしている」と話し、具体的な事例の紹介を行った。

AI エージェント開発は次の 3 つの工程から成り立つ:

- モデル選択

- モデル活用

- AI エージェント化

Google Cloud は、これらの各工程を包括的にサポートするサービス群を提供しており、特に Vertex AI Agent Builder は、AI エージェントの開発を効率化し、開発者のマインドを「どのように開発するか」から「何を開発するか」へとシフトさせることを可能にすると述べた。

淵野氏は、具体的に、クリエイティブやマーケティングのユースケースに特化した AI エージェント、クリエイティブエージェントを紹介した。 クリエイティブエージェントは、マーケティング部門がパーソナライズされたコンテンツを作成したり、リアルタイムで効果的なキャンペーンを展開したりする際に、生成 AI の能力を最大限に引き出すためのアプリケーション。 AI を活用した動画作成アプリケーションである 「Google Vids」や、高品質なテキスト、画像変換モデル「Imagen 3」、最先端の動画生成モデル「Google Veo」について紹介した。

コンテクスチュアル広告の事例

コンテクスチュアル広告:

Web ページのキーワード、文意、画像等を AI(人工知能)が自動で解析し、文脈に合った広告を配信する手法

日本テレビ放送網の辻 理奈 氏は、コンテクスチュアル広告の事例を紹介した。 コンテクスチュアル広告は、コンテンツの内容に沿ったターゲティング広告を配信するもので、コンテンツ内の物体やセリフを検知し、関連性の高い動画広告を配信する。 日本テレビは、Google の Gemini を使って動画から物体、音声、シーンを抽出し、カテゴリ分類を行い、広告配信での活用を行っているそうです。

基調講演ではチャットボットによる抽出データの対話的な検索のデモも行われた。 これまで、ストレージから構造化 DB へと移すフローの中で、Gemini を 6 回呼び出す必要があったが、昨日発表されたコンテキストキャッシングを活用することで、コストとパフォーマンスの採算が取れるようになったそうです。 加えて、AI を活用することで、コンテンツの内容を深く理解し、ユーザの興味関心に合わせた広告を配信することが可能になった紹介しました。

Agent Builder デモ

実際に、Google Chat から質問をすると、Agent Builder を介して BigQuery から情報を取ってくるアプリケーションのデモが行われた。 エージェントのツールや、Gemini の Function Calling を効果的に使う方法、動的に SQL を生成する様子等が披露された。

Gemini によるメリット

辻氏は、開発を通じて、開発スピードの向上、コンテキストキャッシングによるコストとクオリティの両立、Model Garden を活用することで選択肢が豊富になった等、いくつかメリットを挙げた。 生成 AI は PoC から実用化のフェーズへとシフトしており、積極的な Google Cloud の活用によって、それらがさらに推進すると述べた。

クリエイティブエージェント

クリエイティブエージェントとは、クリエイターやマーケターに特化したエージェントです。

Google Vids

Google Vids は Google スプレッドシートや Google ドキュメントと並ぶ、Google Workspace の業務用動画作成アプリケーションです。 Gemini とシームレスに統合されており、ユーザがコンテキスト等を含めたプロンプトを投げるだけで、業務として使用できる高品質な動画が作成できます。 これにより、動画作成がスライドの作成と同じくらいハードルが下がるようです。

Imagen3

Imagen3 は、高度な精度でテキスト生成ができるモデルで、ユーザの意図や背景を汲み取ってくれる最先端画像生成モデルです。

Google Veo

Google Veo は、1 分を超える 1080 px の動画を生成できるモデルで、自然言語を忠実に理解することができます。(年内 Public Preview 予定)

データエージェント

データエージェントは、データ アナリストのように、質問に答えてくれたり、質問を提案してくれるエージェントです。

Google Cloud テクニカルインフラストラクチャ バイスプレジデント兼ジェネラルマネージャーのブラッド カルダー 氏は、データ分析を支援し、データに基づいた意思決定を可能にするデータエージェントの可能性について紹介しました。

Google Cloud では、Gemini in BigQuery を提供することで、データエージェントの構築を支援する。 BigQuery データキャンバスは、自然言語クエリや埋め込み視覚化をサポートするノートブックのような新しい体験を提供し、分析者は質問をするだけでデータ探索や新しい洞察の発見、視覚化の作成とカスタマイズ、定期的な分析のスケジュール設定を行うことが可能。 また、Data Preparation for Gemini in BigQuery が発表され、データ専門家がデータパイプラインの構築を AI の支援によって行うことができます。

さらに、開発者の生産性を向上させるコードエージェントについても紹介された。 エンタープライズ向けのコード支援 AI である Gemini Code Assist は、コード生成や補完を強力にサポートし、アプリケーションの設計、運用、トラブルシューティング、最適化が容易となる。

Gemini in BigQuery

データエージェントの基盤として、Gemini in BigQuery が発表され、開発やデータの準備、インサイトといった、データ分析のワークフローに Gemini が組み込まれる。

Gemini in BigQuery の機能として以下が紹介された:

- BigQuery データキャンバス

- 自然言語と視覚を使ったノートブックのような体験ができる

- マテリアライズドビューの Recommender / パーティションとクラスタリング

- データを最適化し、クエリパフォーマンスを向上できる

- クエリ生成に Gemini を活用

- Data Preparation for Gemini in BigQuery

- AI でデータパイプラインを構築できる

- Vector Indexing in BigQuery

- リアルタイムで正確なベクトル検索ができる

- BigQuery to VertexAI

- BigQuery から Vertex AI モデルに直接アクセスできる

さらに、Looker にも Gemini が統合され、分析結果の自動生成や Look ML ビジュアリゼーション、数式の実行が Gemini によってアシストされる。

データエージェントのデモ

Google Cloud カスタマーエンジニア 高村 哲貴氏よりデータエージェントに商品の売上の分析をさせるデモが実演された。 Gemini データエージェントとの自然言語を使用した対話によって、データの傾向を予測し、その結果をチームに共有するタスクのフローが披露された。

データエージェントの活用事例

ヤマト運輸株式会社 執行役員 輸配送オペレーション システム統括 秦野 芳宏氏より、データエージェントを活用した改革の紹介。

ヤマト運輸では、現場レベルでの改革を追求し、運ぶ力とデジタルの力を組み合わせた改革を、Google Cloud で実現した。 Google Maps と AlloyDB を活用することによって、担当ドライバーの最適化を実現し、さらにドライバーの知見をシステムに取り入れることできめ細かなサービスを実現。 また、ヤマト運輸では、グローバルなアジャイル開発で現場と迅速に連携し、エンジニアだけでなくドライバーも入って開発をしたとのことです。 この取り組みの意義は、社会課題解決のモデルケースになること、世界のラストマイル配送に貢献することであると述べました。

コードエージェント

コードエージェントは、開発者に対してアプリケーション構築の迅速な開発をサポートするエージェントで、設計から運用、トラブルシューティングまで最適化が支援されます。 Google Cloud の代表的なコードエージェントに、Gemini Code Assist があります。

Gemini Code Assist

Gemini Code Asist はエンタープライズグレードのコード支援ツールで、グローバルフットプリントによって世界中の開発者に最適化されている。

今回、Gemini Code Assist の新機能として以下の 3 つが発表された:

- コードアシストで Gemini 1.5 モデルを日本語サポート

- IDE での直接使用

- リファクタリング機能の追加

Gemini Cloud Assist

Gemini Code Assist との連携によって開発者とオペレータ(インフラの運用者)の体験を向上するべく、Gemini Cloud Assist が発表された。

コードエージェントの活用事例

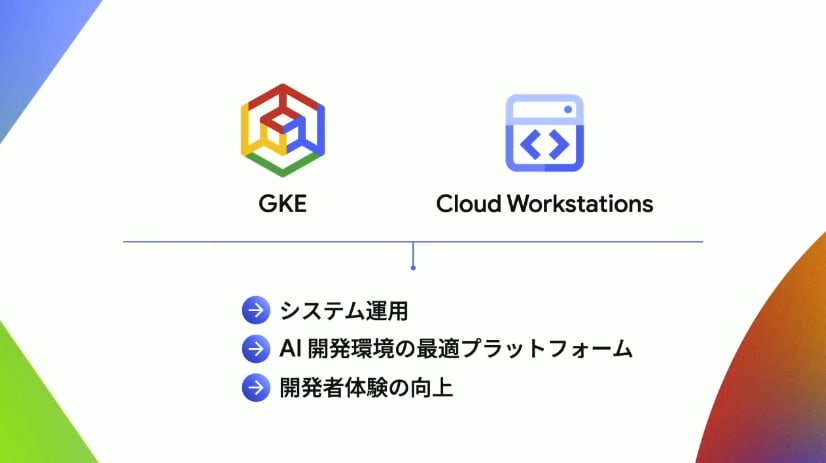

トヨタ自動車の後藤 広大氏より、製造現場における AI 活用について紹介がありました。

トヨタでは、GKE を使った 内製の AI プラットフォームを構築し、製造現場のスタッフが自ら AI を実装できるようにしている。 Autopilot や Image streaming を活用し、GPU の効率的な利用を可能にし、Pod の起動時間を 75 % 短縮、コストを 20 % 削減したと語りました。 さらに、Cloud Workstations を導入したことで、開発環境の構築、維持管理、セキュリティ対策の工数を効率化し、開発者体験も向上したとのことです。

また、Gemini Code Assist を検証し始めていることについても触れ、Gemini の強力なコード生成・補完機能により、開発者の生産性向上に繋がると見込んでいるようです。

データベースの最新情報:Spanner と Bigtable

Google Cloud データベース ジェネラルマネージャー兼バイスプレジデント アンディ ガットマンズ 氏は、生成 AI アプリケーションの基盤となるデータベースの重要性を強調し、Spanner と Bigtable の最新機能を紹介しました。

Spanner は、Google の検索、Gmail、YouTube 等、十億人のユーザを抱えるプロダクトを支える実績がある。 常に稼働し、グローバルに一貫性があり、事実上無制限にスケーリング可能なデータベースである。

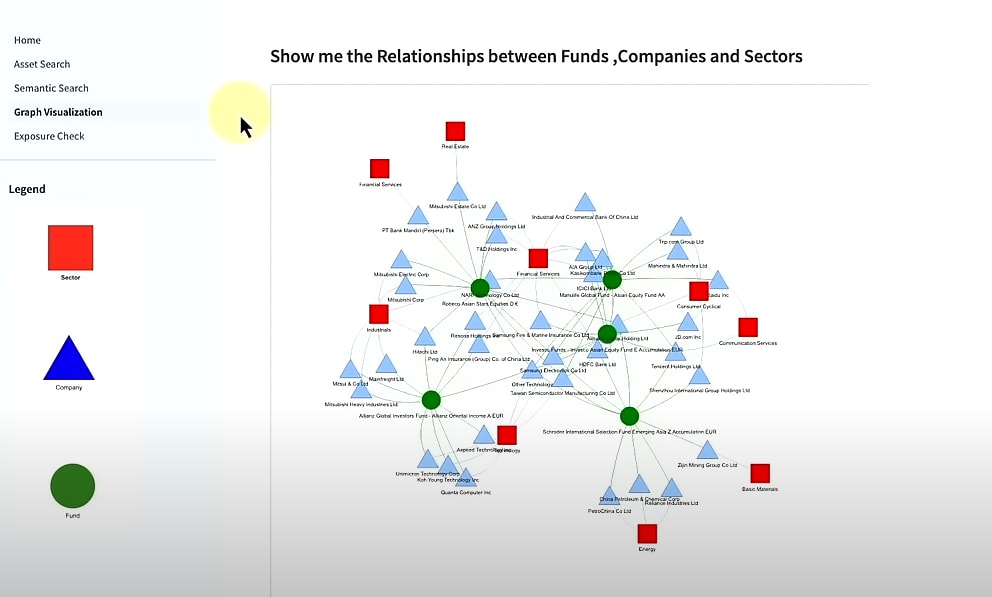

今回は Spanner の一機能として、グラフ処理を事実上無制限の規模で可能にする Spanner Graph を発表した。 また、高度な全文検索とベクトル検索機能も追加され、Spanner は可用性、一貫性、スケーラビリティの特性に加え、インテリジェントな機能を備えたデータベースへと進化した。

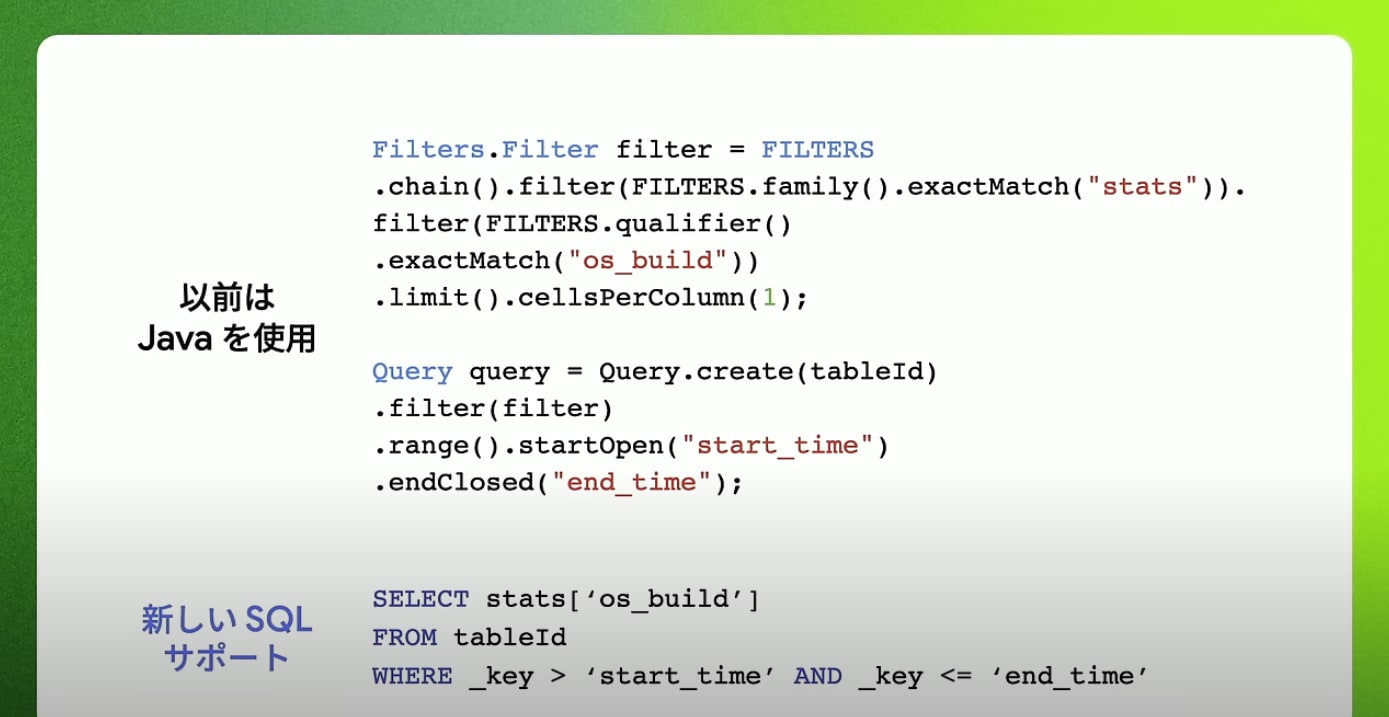

Bigtable は、柔軟なスキーマ、書き込みスループット、低レイテンシが特徴のワイドカラムな KVS である。 今回は、Bigtable 分散カウンタが一般提供となり、Bigtable SQL のサポートが発表された。 Bigtable SQL を使用すると、既存の SQL スキルを活用して Bigtable データを照会できるようになる。

続いて、Google Cloud アンディ ガットマンズ氏より、Google Cloud のデータベースのたくさんの嬉しい発表がありました。

Spanner Graph と検索の強化

Spanner で GQL(Graph Query Language)がサポートされるようになり、グラフ処理が可能となる。 これにより、ナレッジグラフやグラフベースの検索拡張生成(Graph RAG)が実現できる。

さらに、高度な全文検索と AI 主導のセマンティック検索も可能になり、Spanner を使用した AI アプリケーションの構築、実行が強化される。 これらの機能により、Spanner の有する可用性、一貫性、スケーラビリティを活用した新たな AI アプリケーションの可能性を見出せると語った。

また、Spanner エディションとして、段階的な価格設定モデルも発表された。

Bigtable の新機能

Bigtable で SQL がサポートされ、100 を超える SQL 関数が Bigtable で直接利用できるようになる。 これまで、Bigtable を使用するにはたくさんのコードを書く必要があったが、SQL を通して簡単に使用できるようになる。 これにより、ログ処理のための JSON の操作から、リアルタイム分析のためのデータスケッチの使用まで、さまざまなユースケースでのリアルタイムなアプリケーションの構築が容易となることが見込まれる。

また、Bigtable 分散カウンタの一般提供が発表された。 Bigtable 分散カウンタは、高スループットの書き込み時間集計に最適化されており、AI、不正検出、データメッシュ、レコメンデーション等のユースケースが期待できる。

Cloud SQL の新エディション

Cloud SQL for SQL Server の Cloud SQL Enterprise Plus エディションのリリース発表があった。 読み取りパフォーマンスが最大 4 倍向上し、99.99 %の高い可用性と高度な災害復旧(DR)が実装されている。

Oracle との新たなパートナーシップ

Oracle のデータベースサービスを Google Cloud データセンタ内でホストし、Google Compute Engine 上でオラクルのデータベースとアプリケーションを実行できるようになるとのこと。

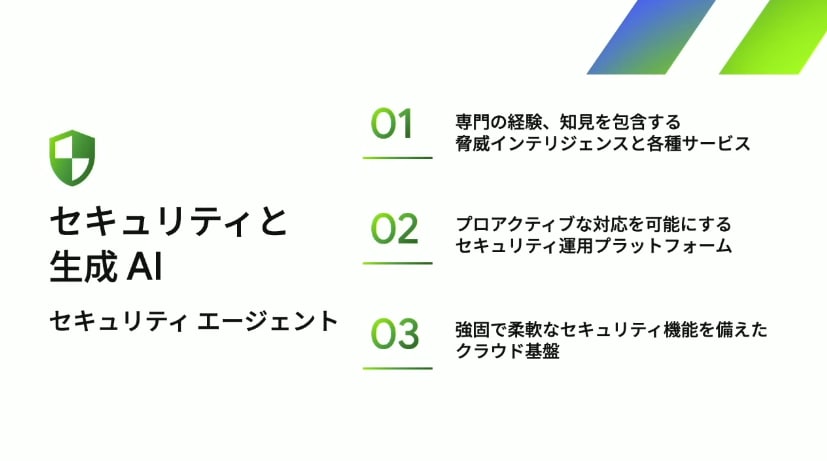

セキュリティと生成 AI

Google Cloud 橋村 抄恵子 氏よりサイバー脅威の状況と、Google Cloud が提供するセキュリティソリューションの紹介がありました。

Mandiant の M-Trends レポートによると、攻撃者が標的組織のネットワークに侵入してから検知されるまでに 9 日間、ランサムウェア攻撃を除くとこの滞留時間は 26 日に跳ね上がっていると報告されている。 また、ゼロデイ攻撃の増加、セキュリティ対策をかいくぐる攻撃手法等、脅威がより複雑化、巧妙化していることも指摘。 このような状況の中、Google Cloud は、脅威インテリジェンス Google Threat Intelligence、セキュリティ運用プラットフォーム Google Security Operations と、Security Command Center、これらのツールと Gemini の統合を実現し、セキュリティのライフサイクル全体を支援すると発表。

Gemini in Threat Intelligence

Gemini を組み込んだ分析によって、コードの分析結果に加えて、その根拠の解説までを実現。

Google Security Operations

Gemni によって、質問だけでログの分析、サマリがプロンプトベースで迅速にできる様子を紹介。 調査時間を 7 分の 1 まで削減できるとのこと。

Gemini in Security Command Center

クラウドセキュリティの強化だけでなく、AI ワークロードの保護等、AI を守ることが強調され、セキュア AI フレームワークを構築できるようになる。

Model Armor

モデルに対して、カスタムポリシやコンテンツのセーフティフィルタを設定できる。 これにより、不適切なプロンプトや応答からモデルを保護できるようになる。

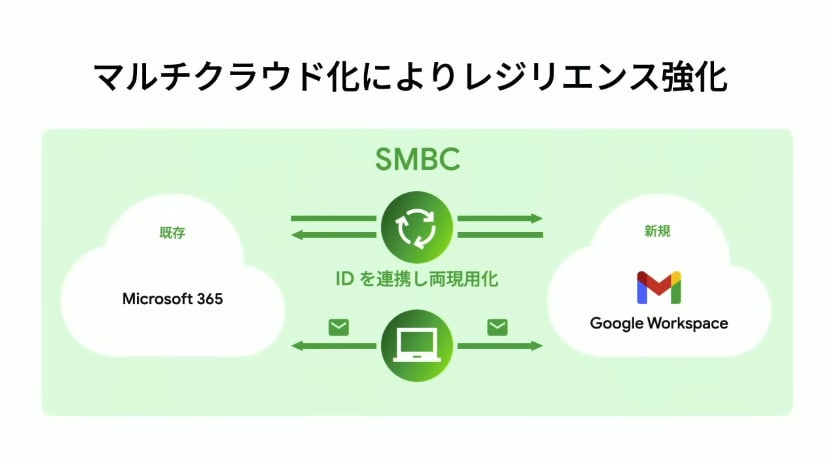

デジタルワークプレイス環境のレジリエンス強化

Google Cloud 執行役員 グローバル スペシャリティセールス Google Workspace 事業本部 上野 由美氏と株式会社三井住友フィナンシャルグループ 常務執行役員(Chief Data and Analytics Officer)高松 英生氏の対談が行われました。

三井住友のイノベーションの歴史から、現代においてどのようにイノベーションを生み出しているのかが高松氏から語られた。 また、Microsoft Office 365 と Google Workspace を連携したマルチクラウドによってレジリエンスを強化していると述べた。

高松氏は、今後の展望として IT 領域の攻めと守りを両立しながらイノベーションを進めていくと強調した。

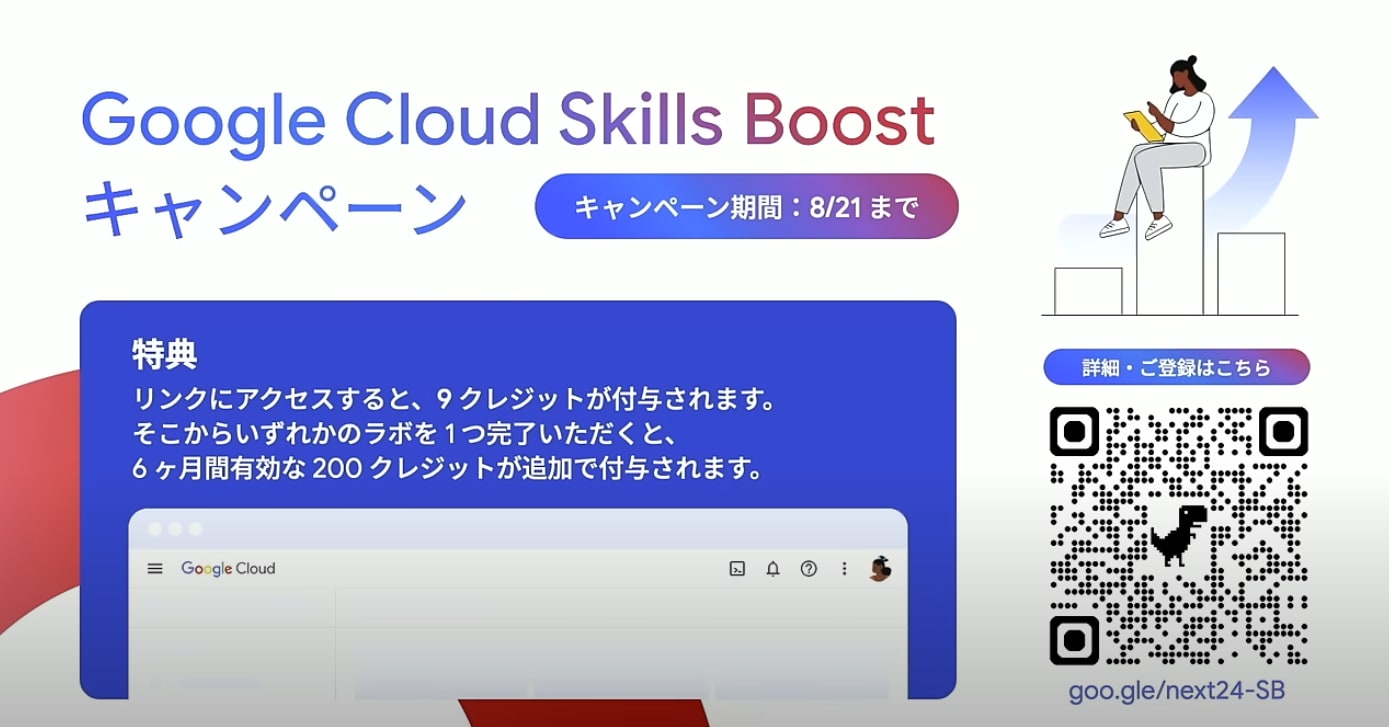

最後に

渕野氏から Google Cloud Skills Boost のキャンペーンが発表されました。 Google Cloud Next'24 Tokyo の開催を記念して、クレジットが貰えるそうです。 これを機に第 9 期となる Google Cloud Skills Boost に参加しようと思います!

また、生成 AI Innovation Awards の開催が発表され、最優秀者は来年ラスベガスで行われる本国 Google Cloud Next'25 に招待されるそうです。 合わせて、日本でも Google Cloud Next'25 Tokyo の開催が決定したと発表がありました 🎉

最後に、渕野氏は、生成 AI はエージェントによるビジネス活用のフェーズに移行していると述べ、Google Cloud はビジネスニーズに応じて柔軟に AI を活用できるようにきめ細かい製品を提供し、AI 時代における重要な基盤であり続けると強調しました。

基調講演 - Day 2 所感

Day 2 も AI の動向や活用事例に関する話題が盛りだくさんでした。 生成 AI は PoC 段階から実用化のフェーズに確実にシフトしてきていることが伝わってきました。

これまで、AI はデータサイエンティストや ML エンジニアの専門的な知識のみによって普及・導入される印象でしたが、AI エージェントの登場によって誰でも手軽に扱えるようになる、いわゆる、AI の普及を AI がサポートする時代が来る と感じました。

2 日間の基調講演を通じて、生成 AI は、BigQuery や Looker のような BI ツールだけでなく、運用基盤やデータベースシステム、さらにはセキュリティツールまで、ありとあらゆる場面で活用されてきている実態が把握できました。 Google Cloud の勢いも非常に熱いため、今後 GCP のありとあらゆる機能に Gemini をはじめとする生成 AI が張り巡らされてくるのだろうと思います。

セッション

基調講演に続き、2 日間で計 10 本のセッションを聴講してきました。

- Day 1

- Day 2

中でも Ubie のモニタリングベストプラクティスや、リクルートの FinOps 推進事例に関するセッションが興味深かったので、改めてまとめておこうと思います。

【Day 1】Ubie:Google Cloud モニタリングベストプラクティス

- 8 月 1 日(木)16:00 - 16:30

- https://cloudonair.withgoogle.com/events/next-tokyo-24?talk=d1-app-05

Ubie 株式会社 坂田 純 氏

Product Platform Div Head of Platform Engineering

Google Cloud Observability は、Google Cloud にネイティブに統合された強力なモニタリングのプロダクト群です。このセッションでは特に Cloud Monitoring にフォーカスし最新情報とベスト プラクティスを紹介します。また Ubie では、5 年以上ほぼ Cloud Monitoring のみを利用しておりこの事例についても取り上げます。

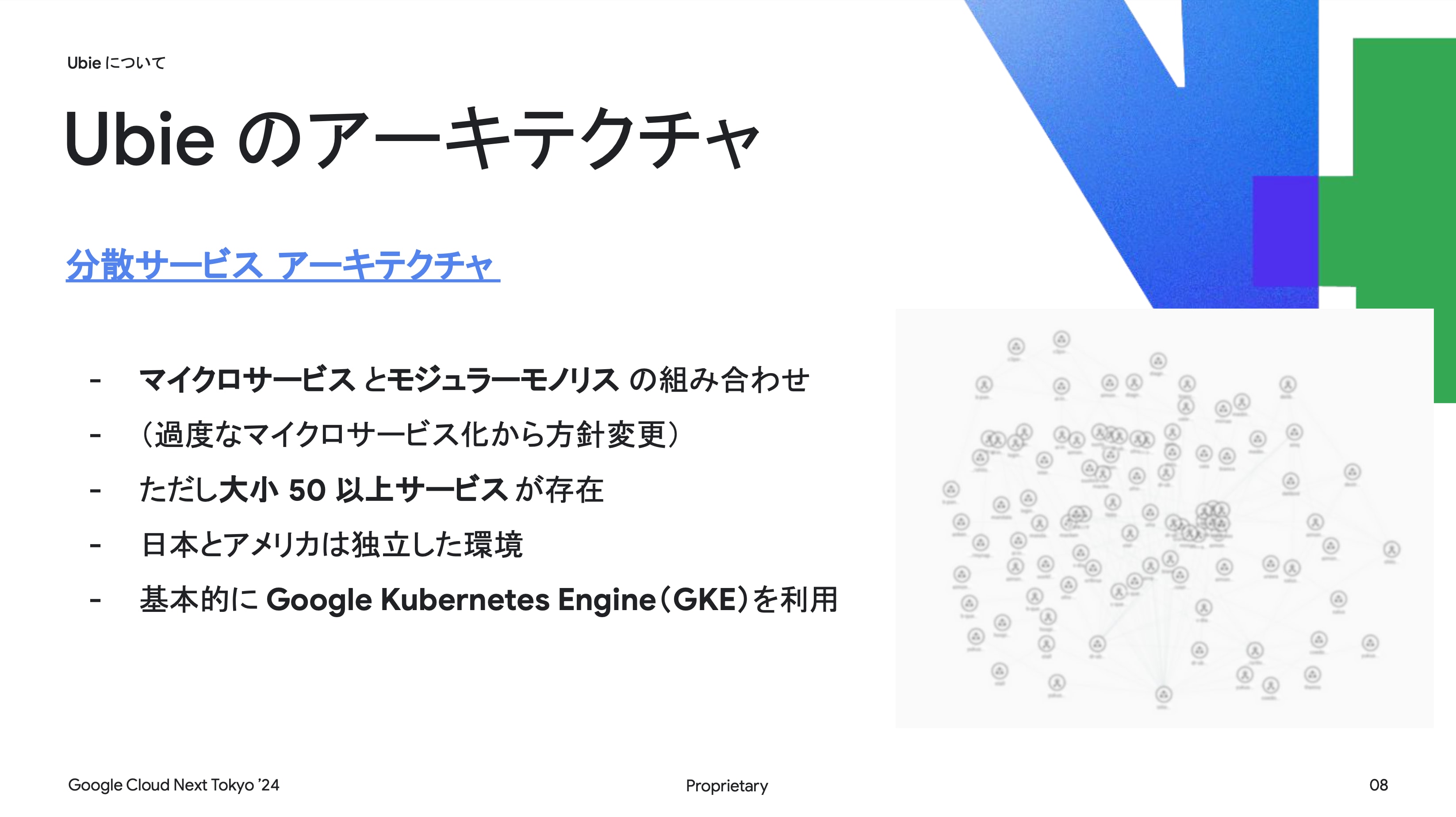

Ubie のアーキテクチャ

- 分散サービスアーキテクチャ

Ubie はマイクロサービスとモジュラモノリスの組み合わせを採用した分散サービスアーキテクチャを持っており、過度なマイクロサービス化から方針を変更して大小 50 以上のサービスが存在する。 クラウドプラットフォームは、日本とアメリカで独立した環境を持ち、どちらも基本的に GKE を利用している。

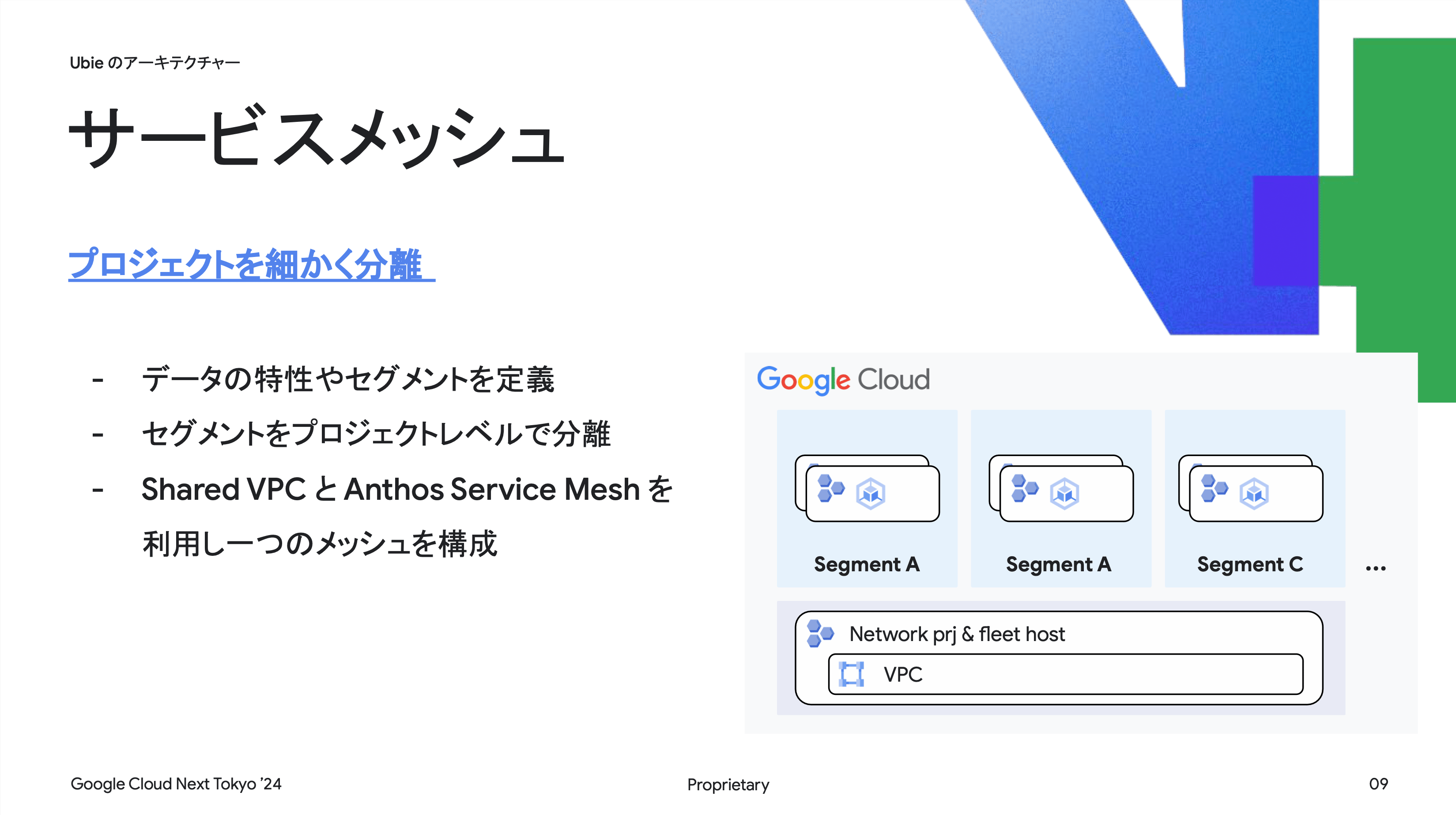

- サービスメッシュの導入

プロジェクトを細かく分離し、データの特性やセグメントを定義することで、セグメントをプロジェクトレベルで分離している。 構成は主に、Shared VPC と Anthos Service Mesh(ASM)を利用して一つのサービスメッシュを構築している。

- モニタリング専用プロジェクト

アラートの設定やダッシュボード等を一元化するため、環境毎にモニタリングプロジェクトを作成しメトリクスを集約している。 これにより、1 つのアラート設定が汎用的に適用可能となり、アプリケーション運用基盤側からモニタリング専用のプロジェクトに紐付けることもできる。

Google Cloud's Observability ツール

以下のツールを使用してモニタリングを行っている:

- Cloud Monitoring:モニタリング

- Cloud Logging:ロギング

- Cloud Trace:トレーシング

- Cloud Profiler:プロファイリング

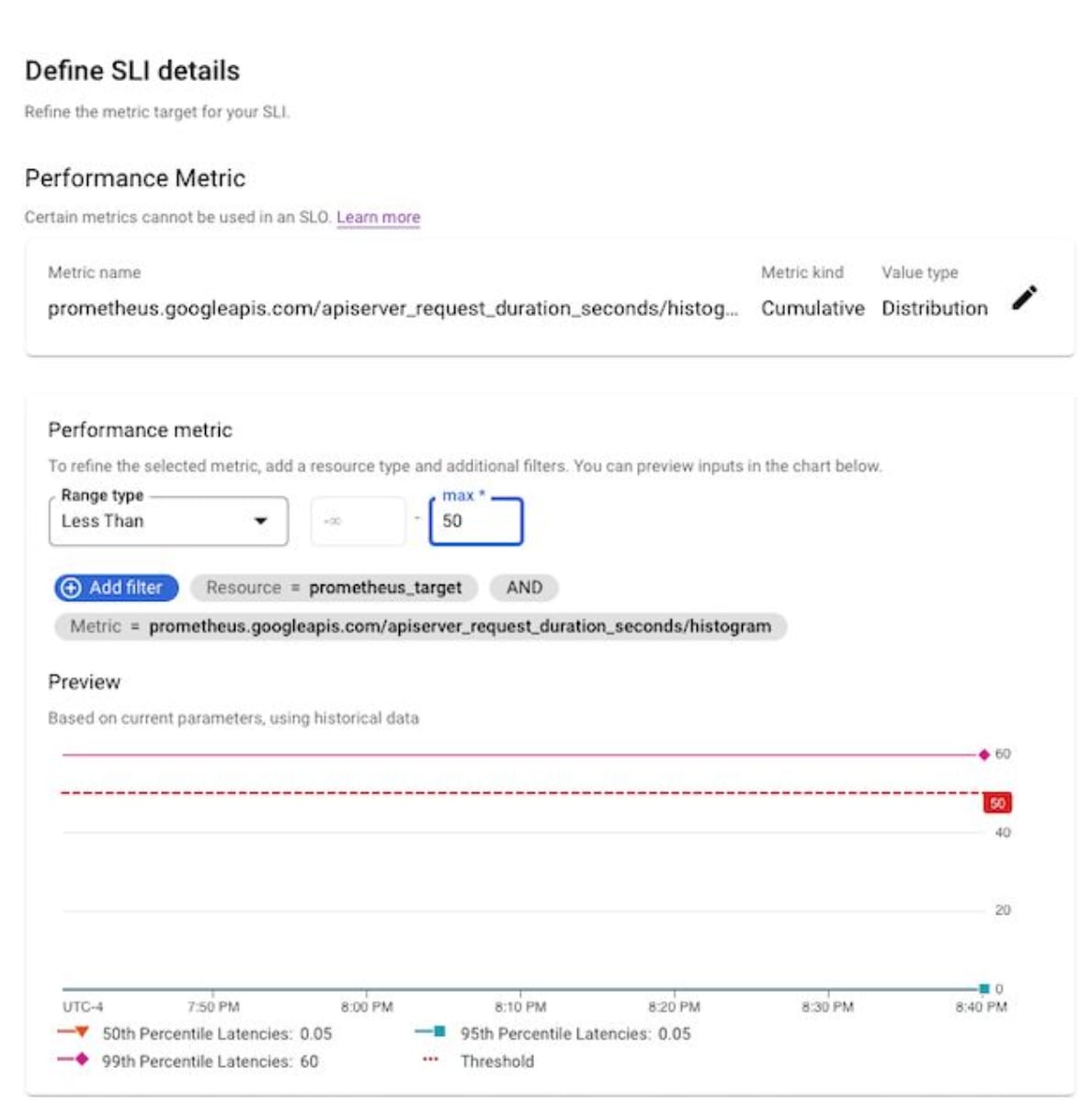

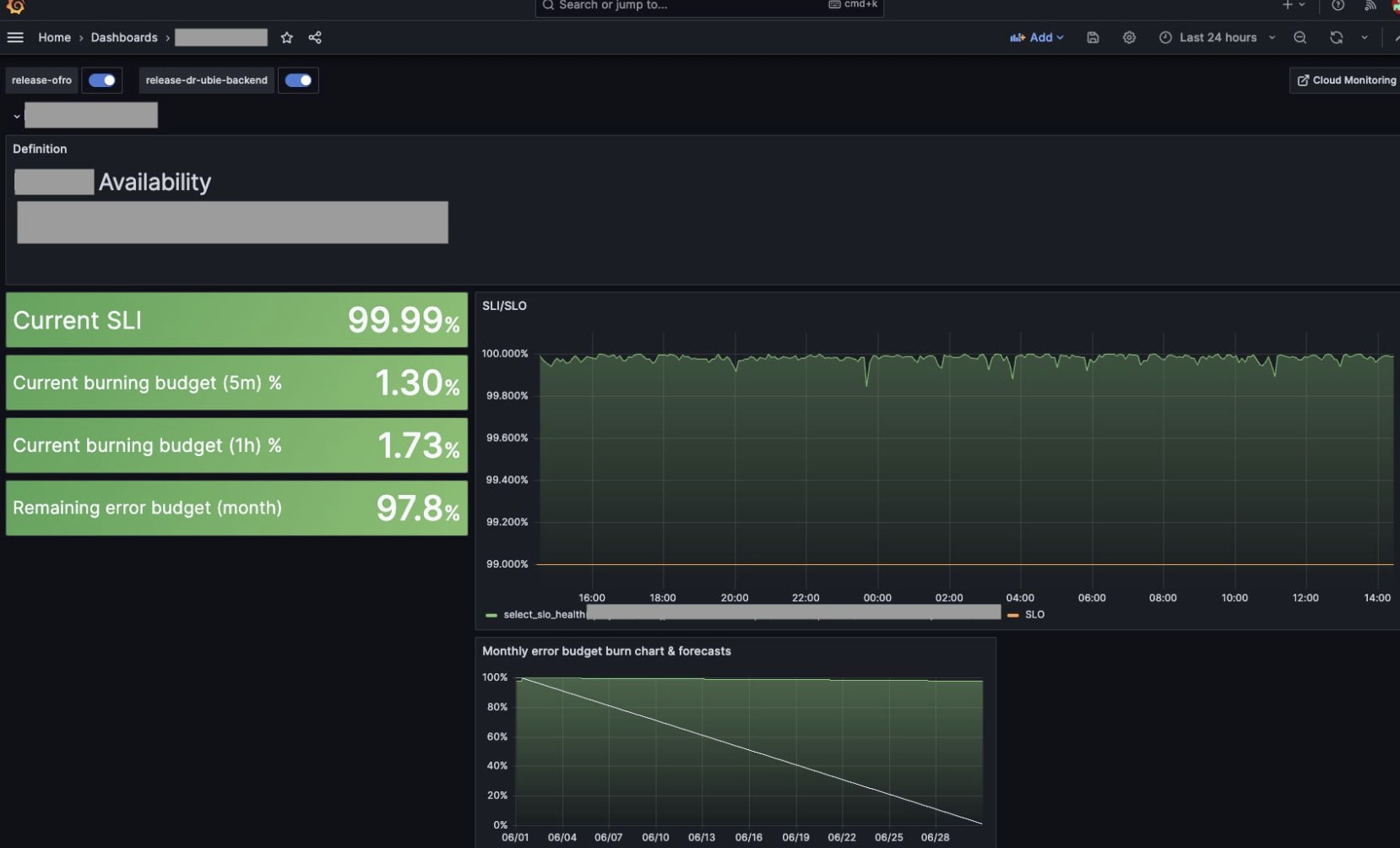

SLO Monitoring

Cloud Monitoring(Google Cloud ネイティブの監視ソリューション)で、各プロダクトのメトリクス、カスタムメトリクスをダッシュボードとして可視化、アラート設定が可能

Ubie では SRE のプラクティスを実践できる環境を整えており、閾値ベースのアラートではなく、SLO やそれをベースとしたアラートの設定も可能となっている。

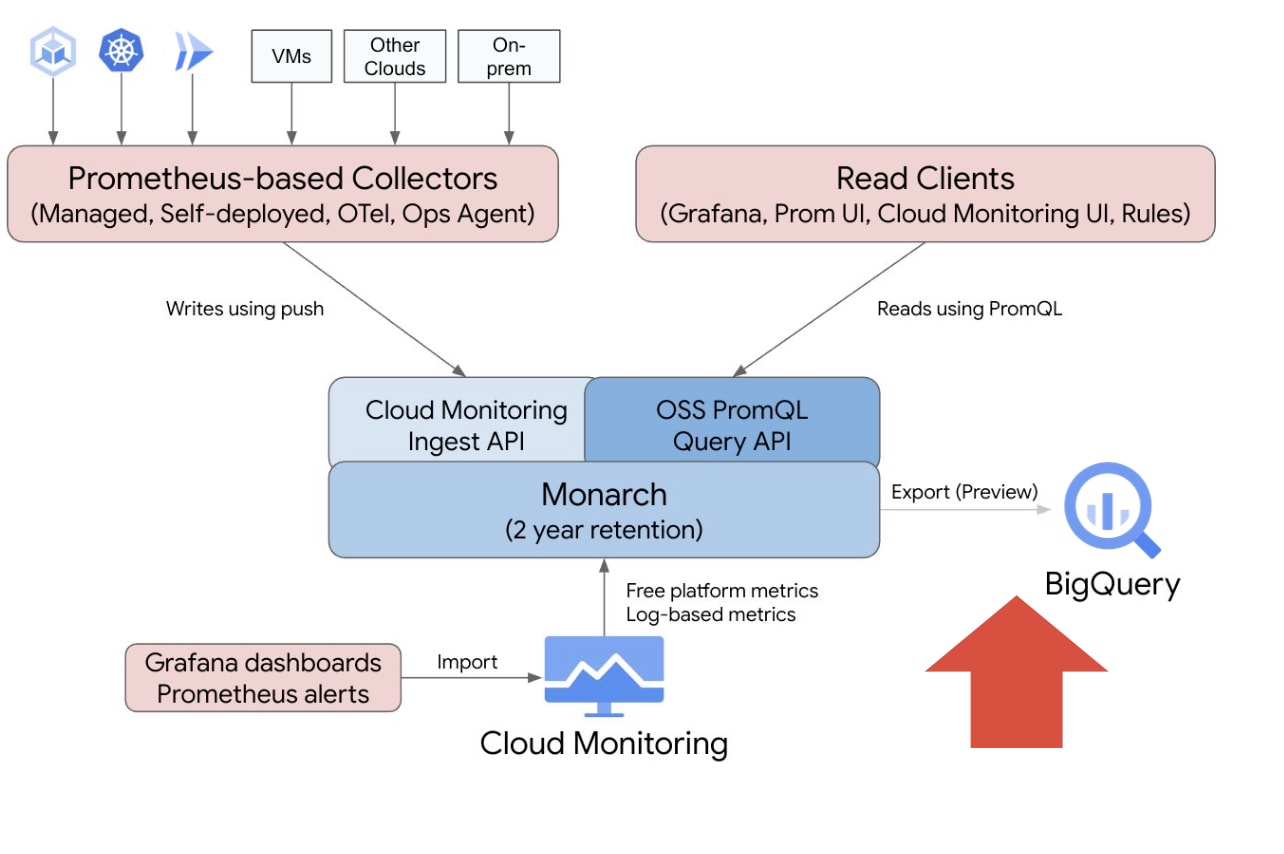

Google Cloud Managed Service for Prometheus(GMP)

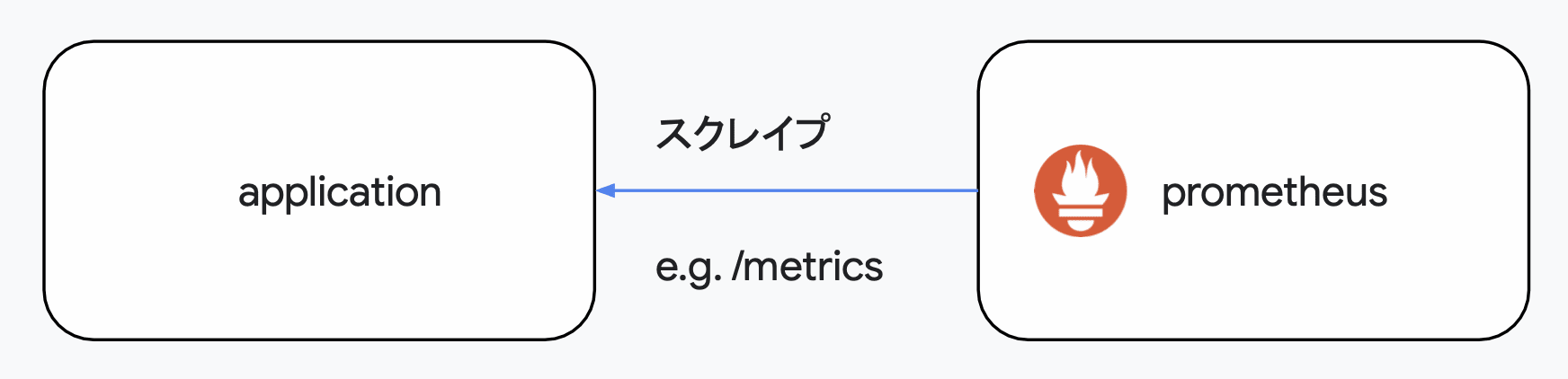

- Prometheus

Prometheus は OSS のモニタリングおよびアラーティングツールで、元々は SoundCloud 社から登場した。 Kubernetes 同様に CNCF のプロジェクトに採用され、クラウドネイティブな環境でデファクトスタンダートとなっている。 各ワークロードは Prometheus 形式でメトリクスを出力すればよい。

一般的なモニタリングエージェントとは異なり、ワークロードからメトリクスをスクレイプする Pull 型アーキテクチャを採用している。 各ワークロードは Prometheus の形式でメトリクスを出力すればよい。

- Prometheus の課題

Prometheus を大規模環境で運用する場合、ストレージやスケーリングの問題が生じる。 長期保存によるストレージの増加やクエリの実行パフォーマンスの最適化を踏まえたストレージ設定、また単一の Prometheus 構成ではスクレイピング等の性能限界の考慮が必要。

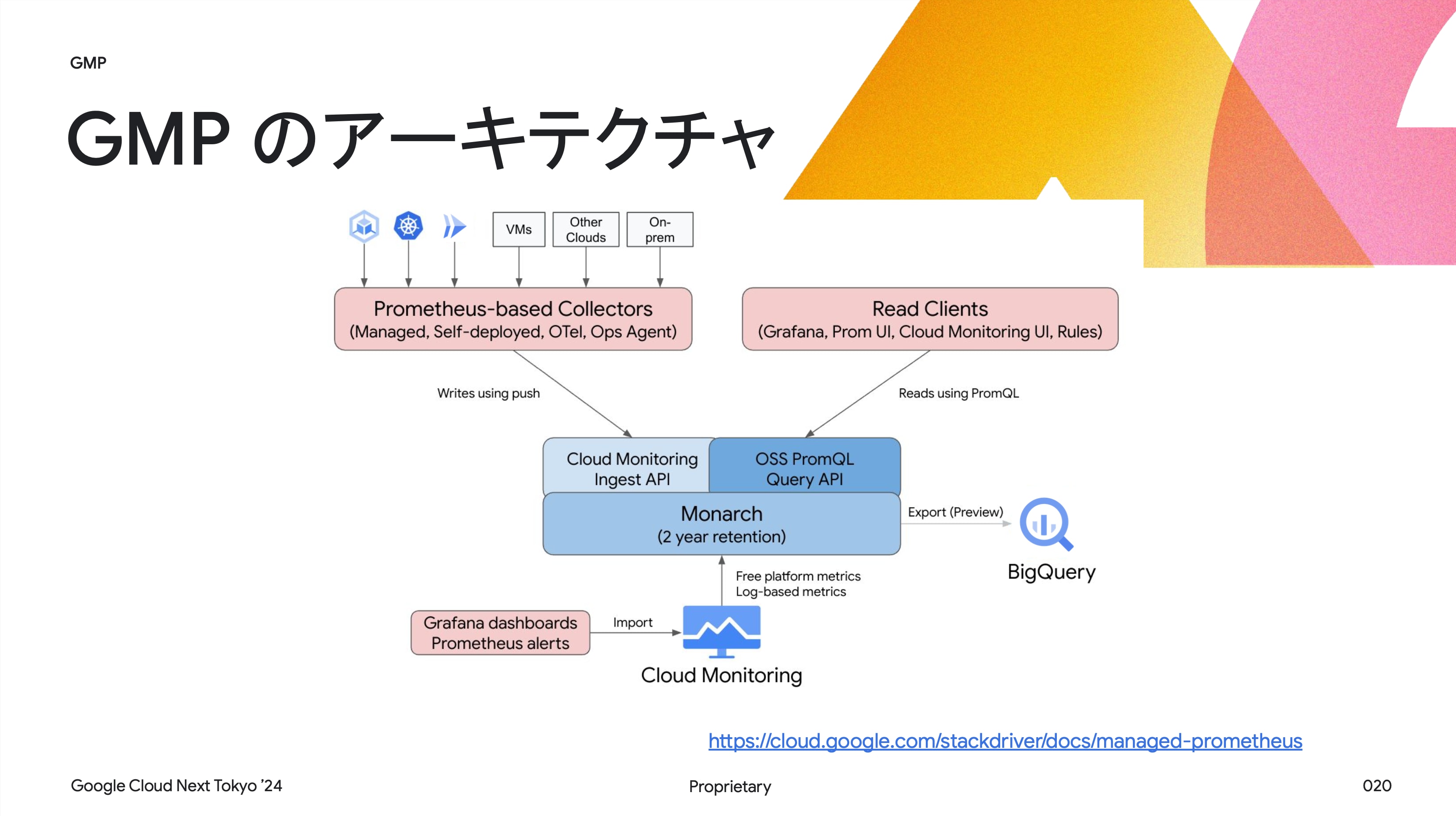

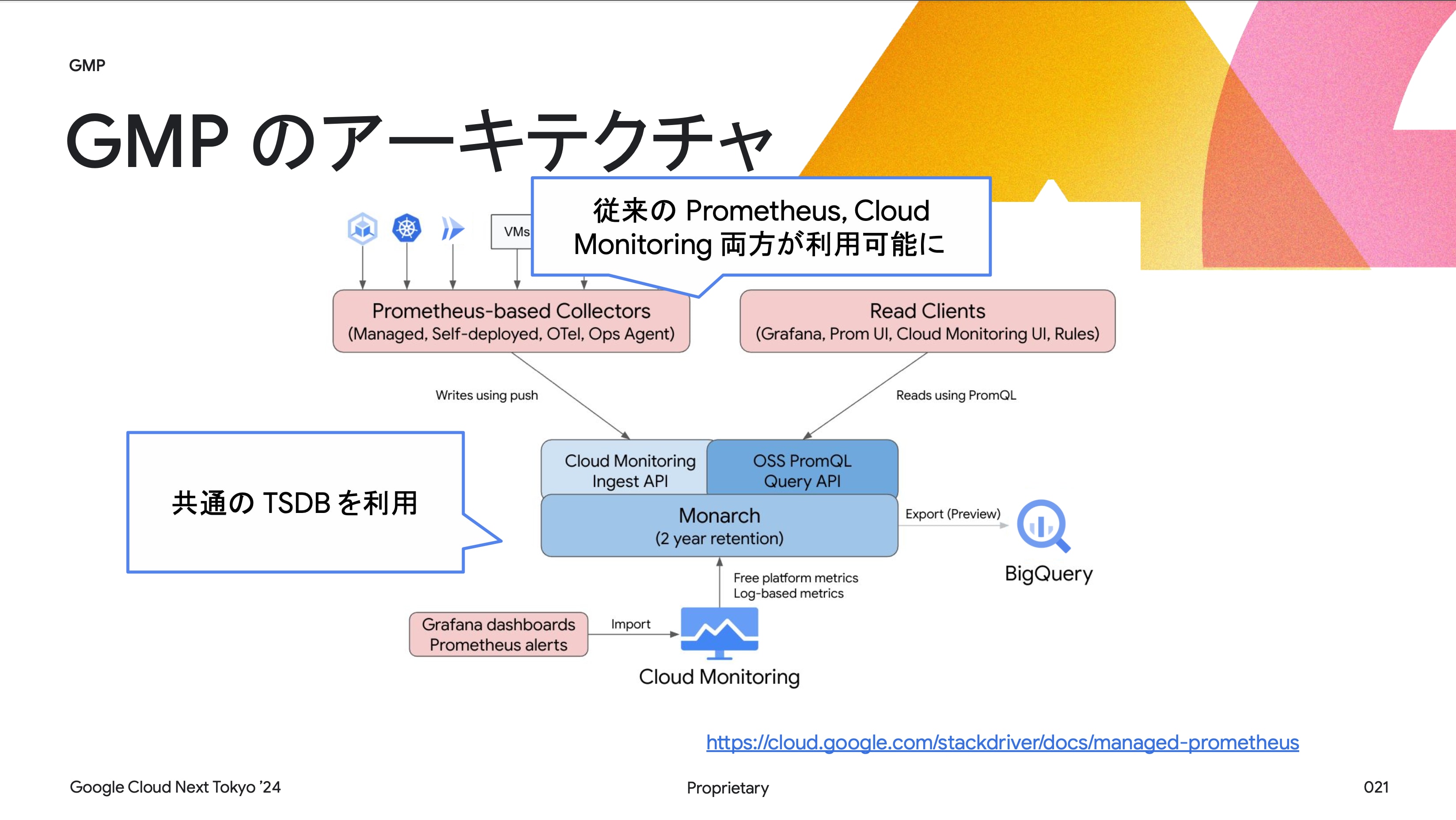

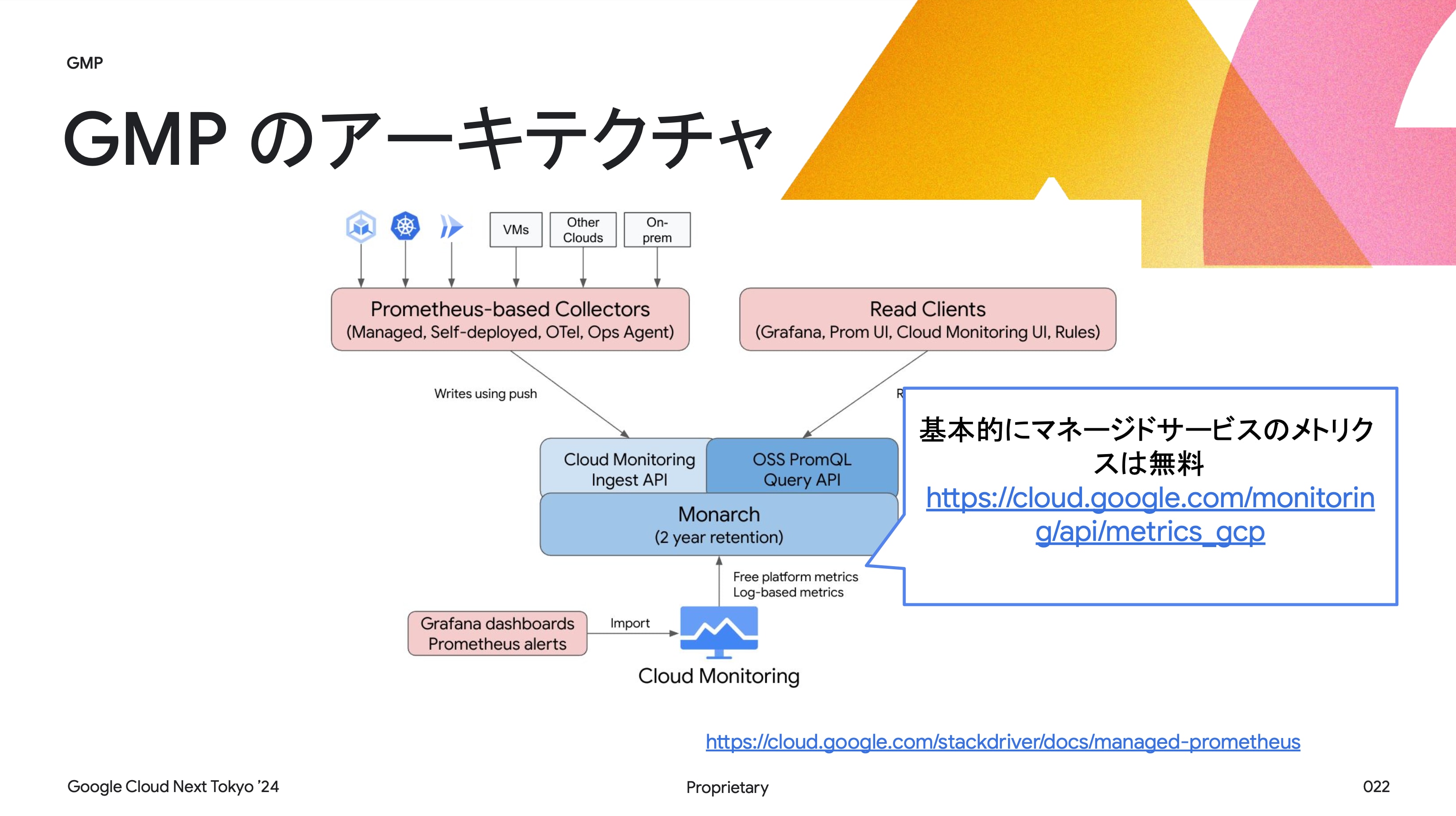

- GMP の概要

GMP は Google Cloud Monitoring が直接サポートする Prometheus(単純に Prometheus がホストされているわけではない) 以前は Prometheus を Cloud Monitoring で利用する方法(Stackdriver 等)があったが、GMP は Monarch というバックエンドを活用し、制限を緩和している。 GMP の利点として、ほぼ無限にスケールするデータベースとメトリクスの収集機構が提供されている。

そのため、本来の Prometheus で気をつける必要があったストレージや冗長性観点では気にする必要がない。 また、カーディナリティ(カラムに格納されているデータの種類がどのくらいあるのか)についても Prometheus ほどシビアではない。

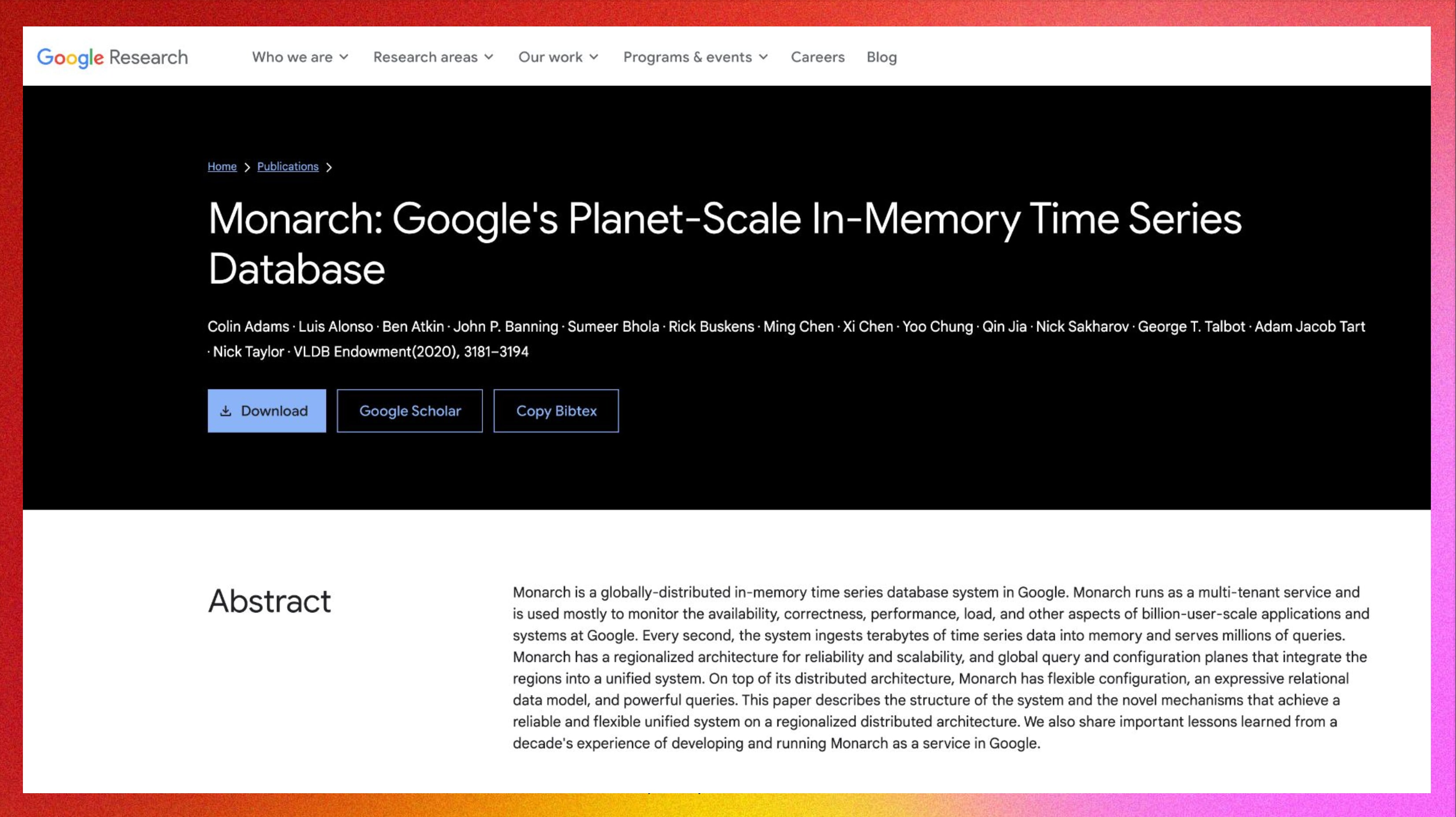

Monarch:Google で運用されているグローバルに分散されたインメモリの時系列 DB

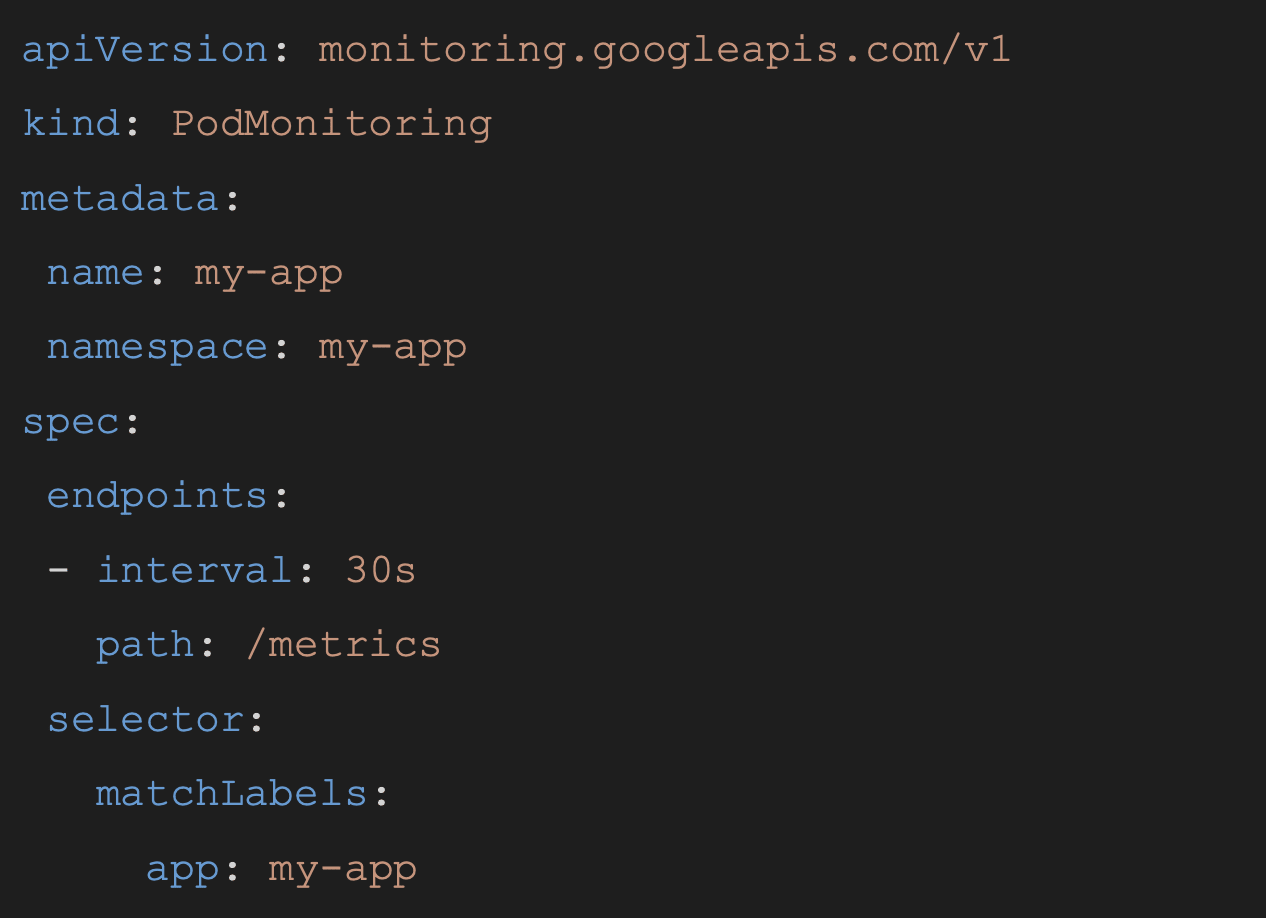

GKE での利用

GKE ではオプションを有効化するだけで CRD が DaemonSet としてインストールされ、簡単にメトリクスを収集できる。 Google の独自規格が用いられているが、Prometheus Operator に近い。

Cloud Run も公式サポート

Cloud Run のアプリケーションのメトリクスもサイドカーを利用することで取得可能。 元々は OpenTelemetry のサイドカーで取得できたが、公式のサイドカーがサポートされた。

PromQL の利用

Cloud Monitoring では全ての機能で PromQL が利用可能。 元々の Cloud Monitoring のクエリ言語 MQL と混在することも可能だが、今後は PromQL が推奨される。

Ubie でのメトリクス運用

メトリクスは大きく以下の 2 つに分類される:

- 共通のメトリクス:主にマネージドサービスのメトリクス

- アプリケーションやマイクロサービス固有のメトリクス:例としてログインの成功率

GMP の利用

Ubie ではサービスメッシュの導入と合わせて Prometheus を導入している。 元々は Prometheus を自前でホスティングしていたが、GMP に移行し、かなりのコスト削減が実現できた。

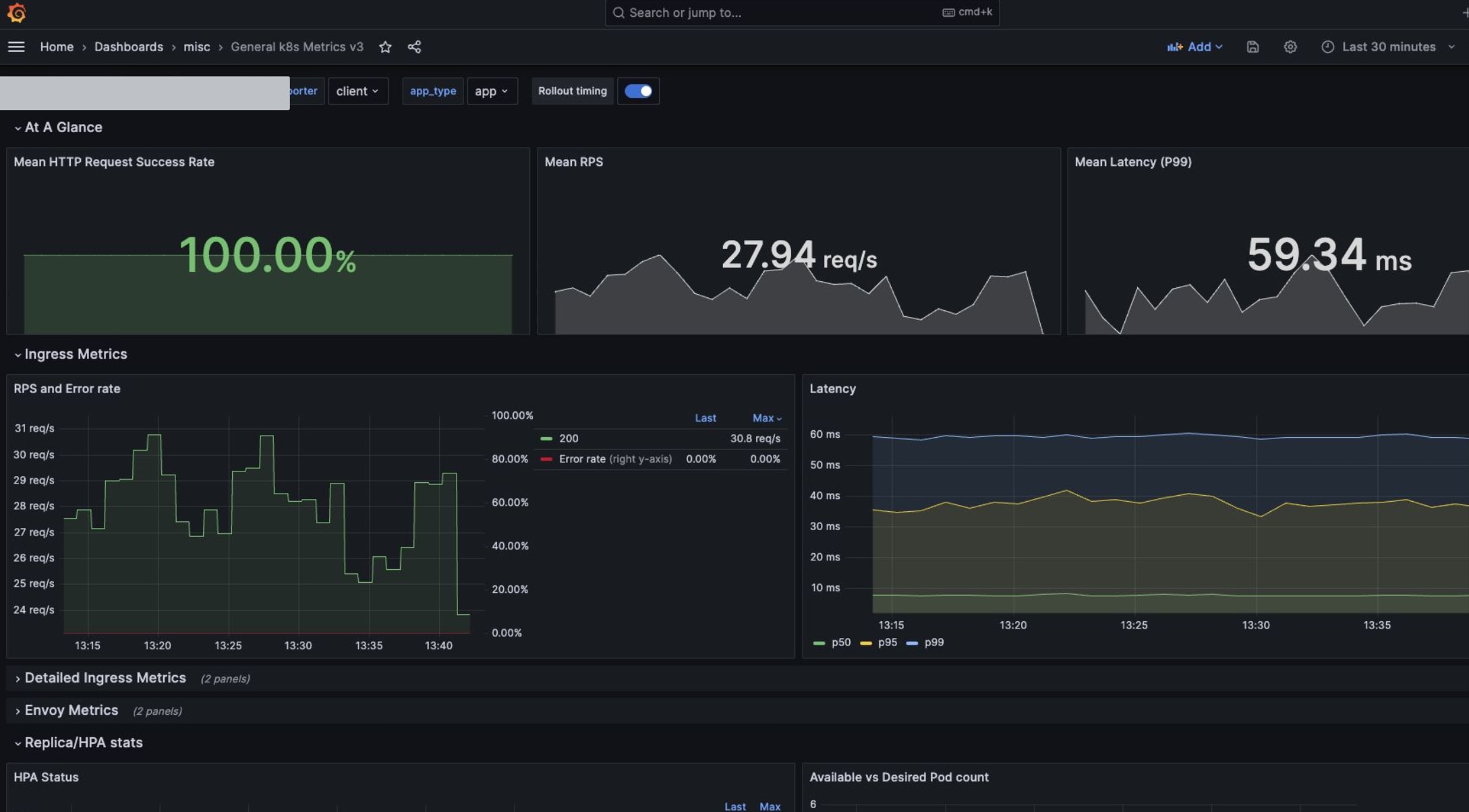

Grafana の利用

- Grafana ダッシュボード

全エンジニアが同じダッシュボードを利用し、Grafana をソースにメトリクスを提供している。(One Grafana 構成) プラットフォームが横断的にトラフィック等のダッシュボードを提供し、各開発チームも自由にダッシュボードを作成できる。

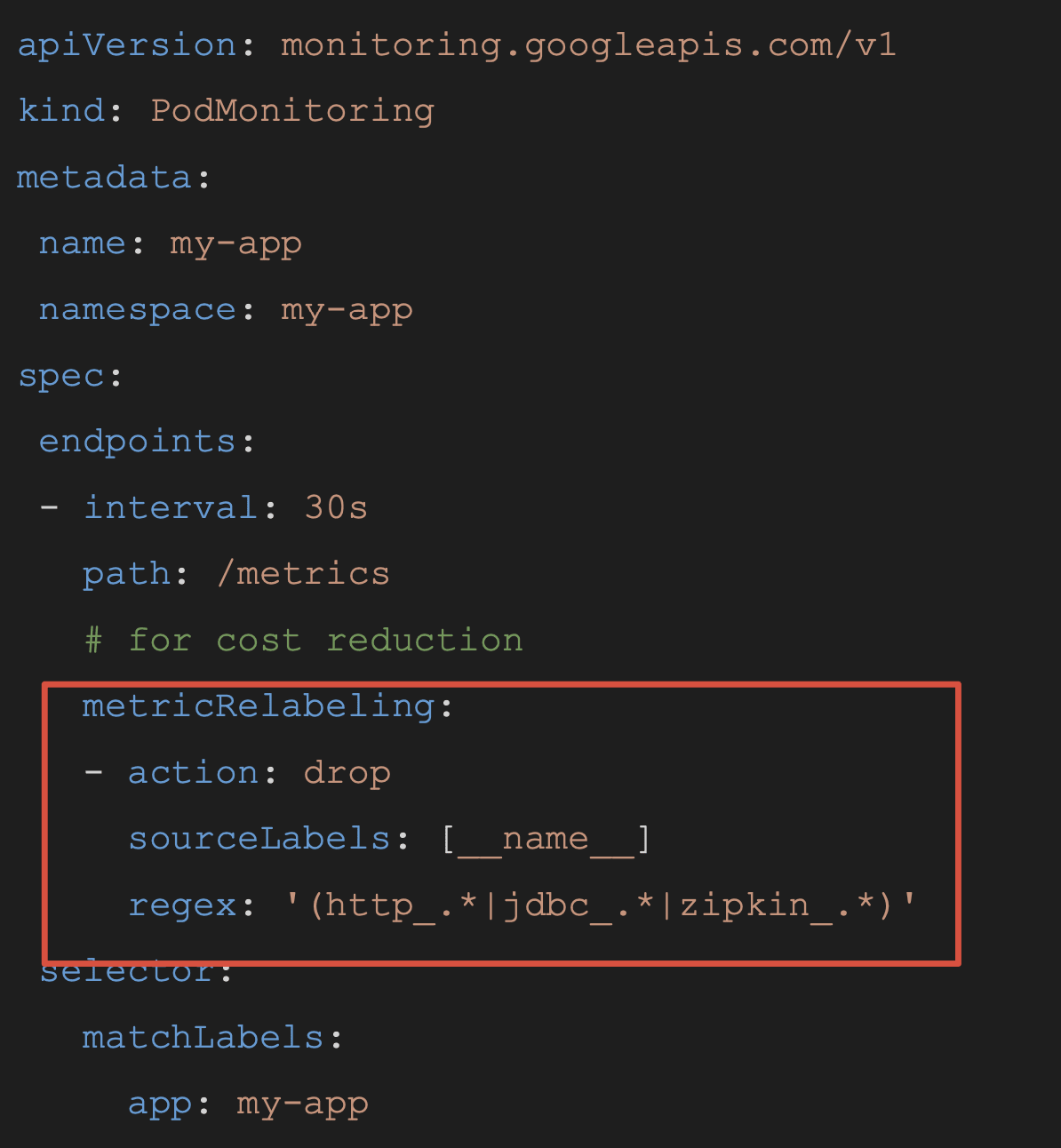

コスト対策

プロダクトの値下げがあったものの、コストコントロールは重要。 CRD で必要なメトリクスのみ取得し、メトリクス種別毎にアラートを設定している。

- 必要なメトリクスのみ取得

特に OSS で公開されている Prometheus Exporter は汎用的に作られているため、利用しないメトリクスも取得してしまう。 そのため、metricRelabeling 等を活用して、不必要なメトリクスを取得しないように落としている。

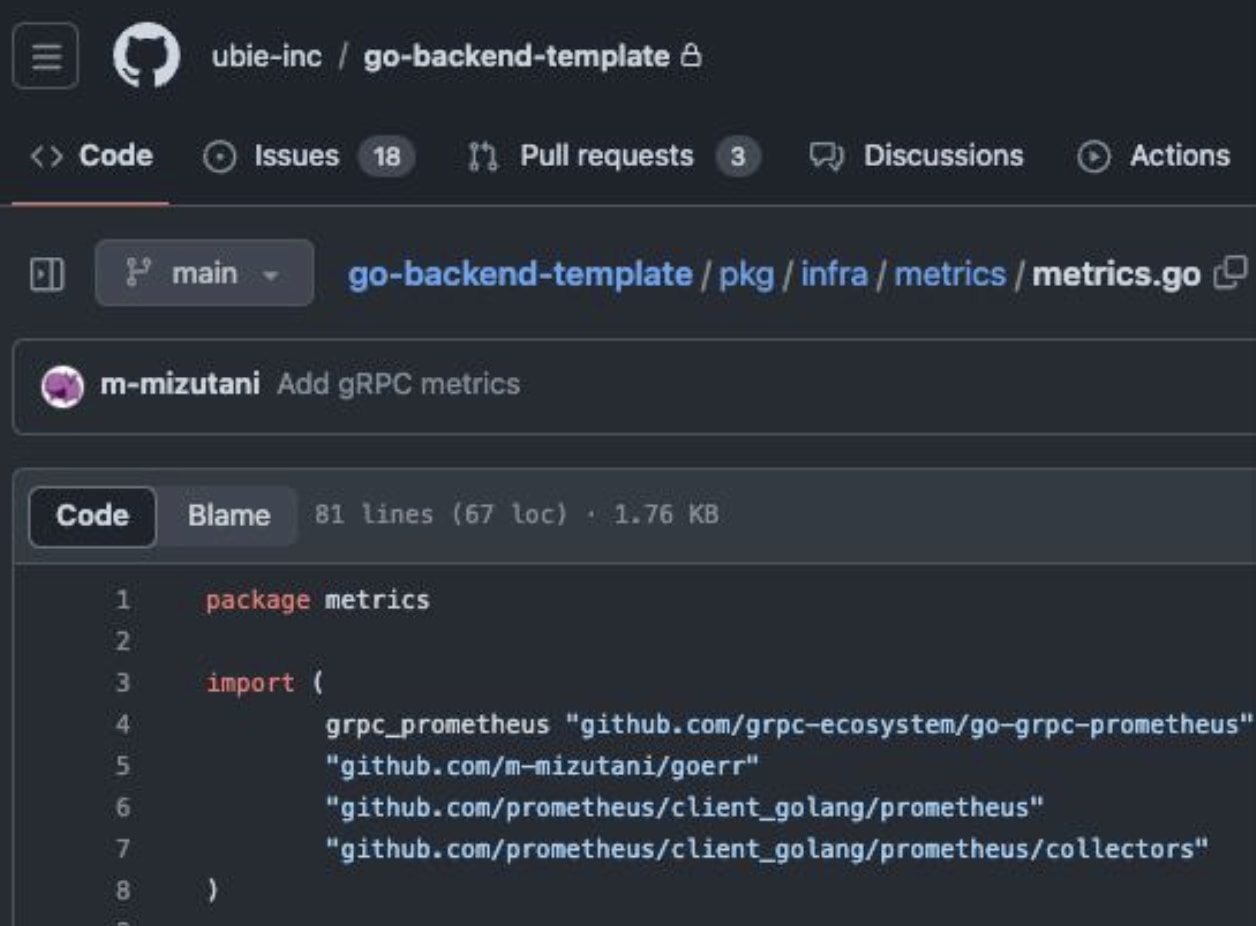

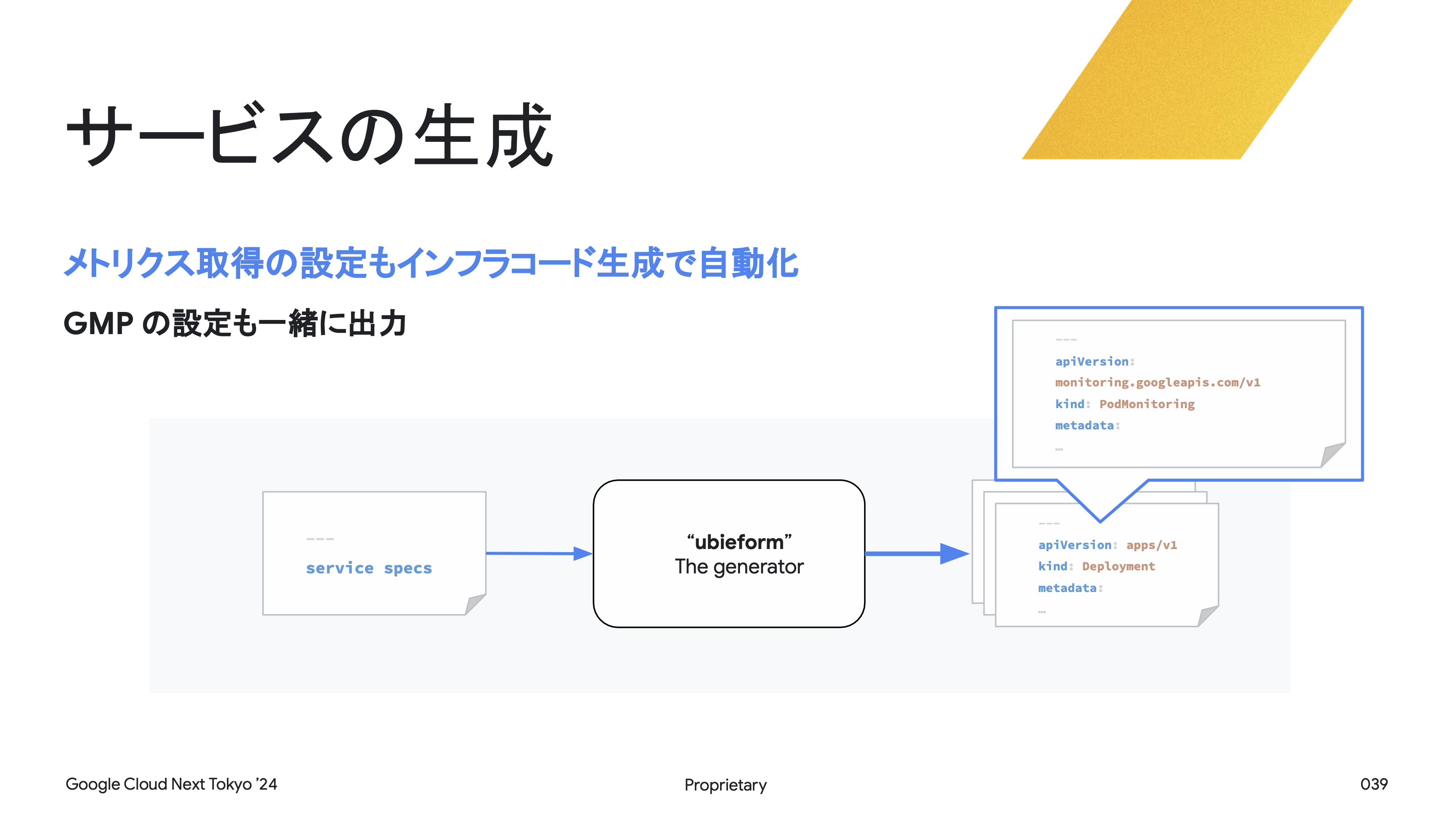

サービス生成とテンプレートの組み込み

- メトリクス取得の自動化

アプリケーションのテンプレートに実装を組み込むことで、サービスの立ち上げをスムーズに行う。 言語レベルのメトリクスは追加実装不要で取得できる。

社内ツールによる生成

ubieform という社内ツールで Kubernetes のマニフェストを生成し、メトリクス取得の設定もインフラコード生成で自動化している。

SLO とサービスカタログの利用

サービス毎の Grafana のダッシュボードや Cloud Logging のメトリクスへのリンクを BackStage に自動的に連携し、開発者サービスのメトリクスやログに辿り着けるようにサービスカタログを用意している。

SLO の可視化

SLO Monitoring は Grafana でも利用可能で、サービスやプロダクト毎に可視化している。

サービスカタログ

開発者がサービスのメトリクスやログにアクセスできるように、各サービスの Grafana ダッシュボードや Cloud Logging へのリンクを BackStage に自動連携している。

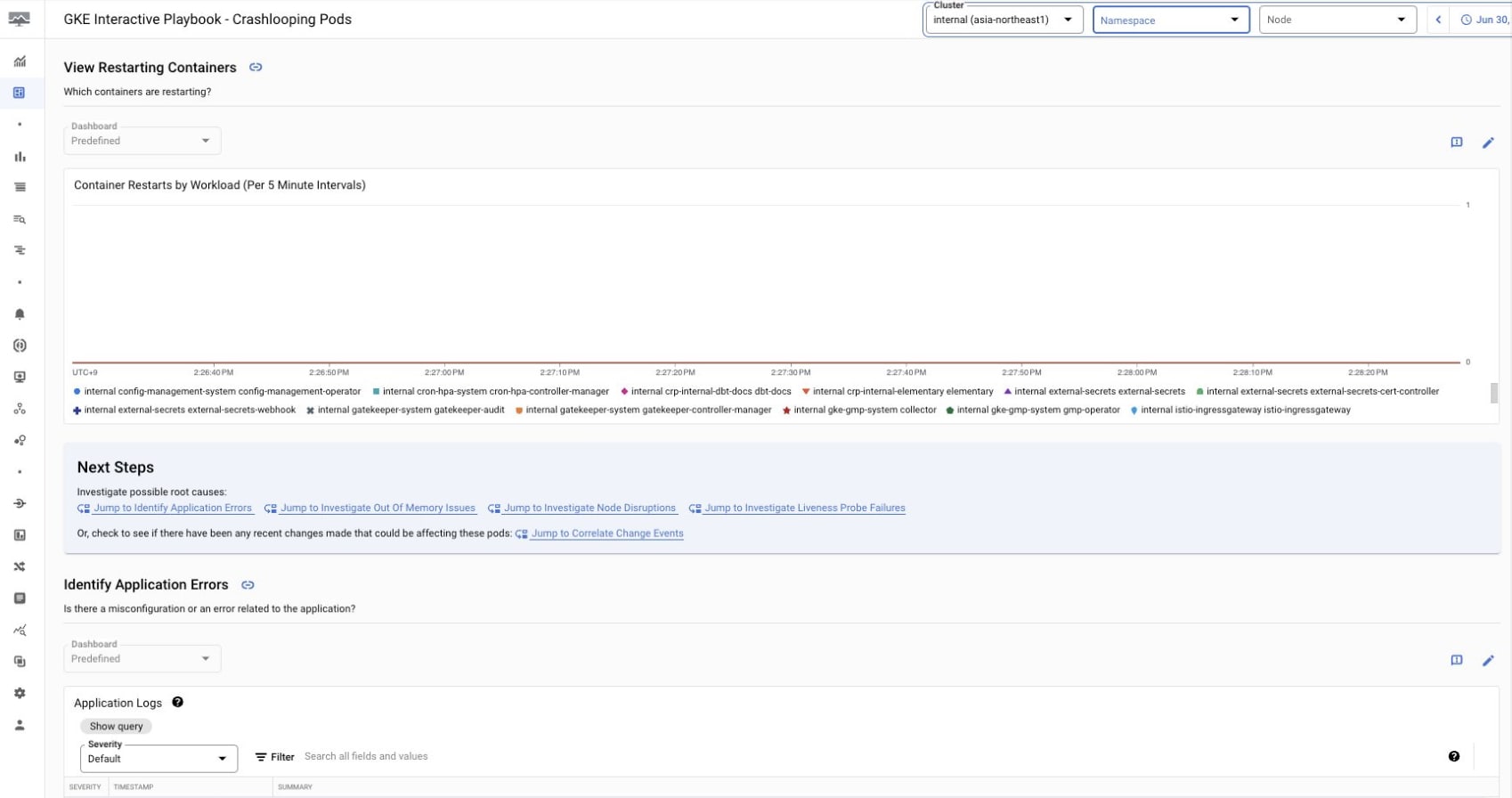

Future Works

あまり知られていない機能だが、かなり便利。 インタラクティブなトラブルシューティングが可能なプレイブックを提供。 ダッシュボードを利用し、コンテナ起動トラブル等に対処するための手順を記載できる。

Obersevability Analysis

ログ・メトリクスが BigQuery からクエリ可能になり、SQL を駆使した包括的な観測が可能になる。

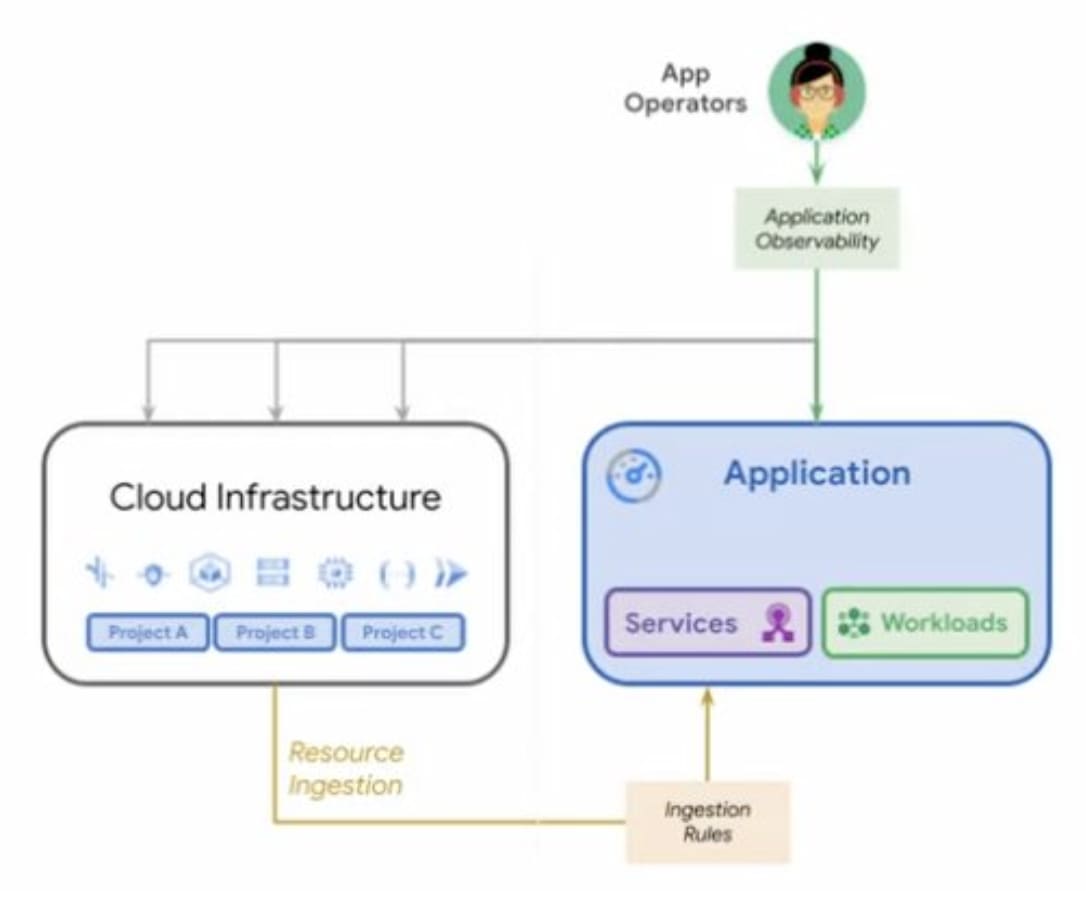

App Hub

クラウドリソースやインフラではなく、アプリケーション中心にオペレーションとガバナンスを強化する。 オペレーション面では機能がまだ不十分であるが、オブザーバビリティも今後に期待している。

現状は GKE、ASM、Cloud Run、Cloud Monitoring 等それぞれのプロダクトでメトリクスの確認や SLO を設定可能だが、インフラに関わらず開発者が一番に利用する場所として期待。(自分たちで BackStage を管理しなくていいように)

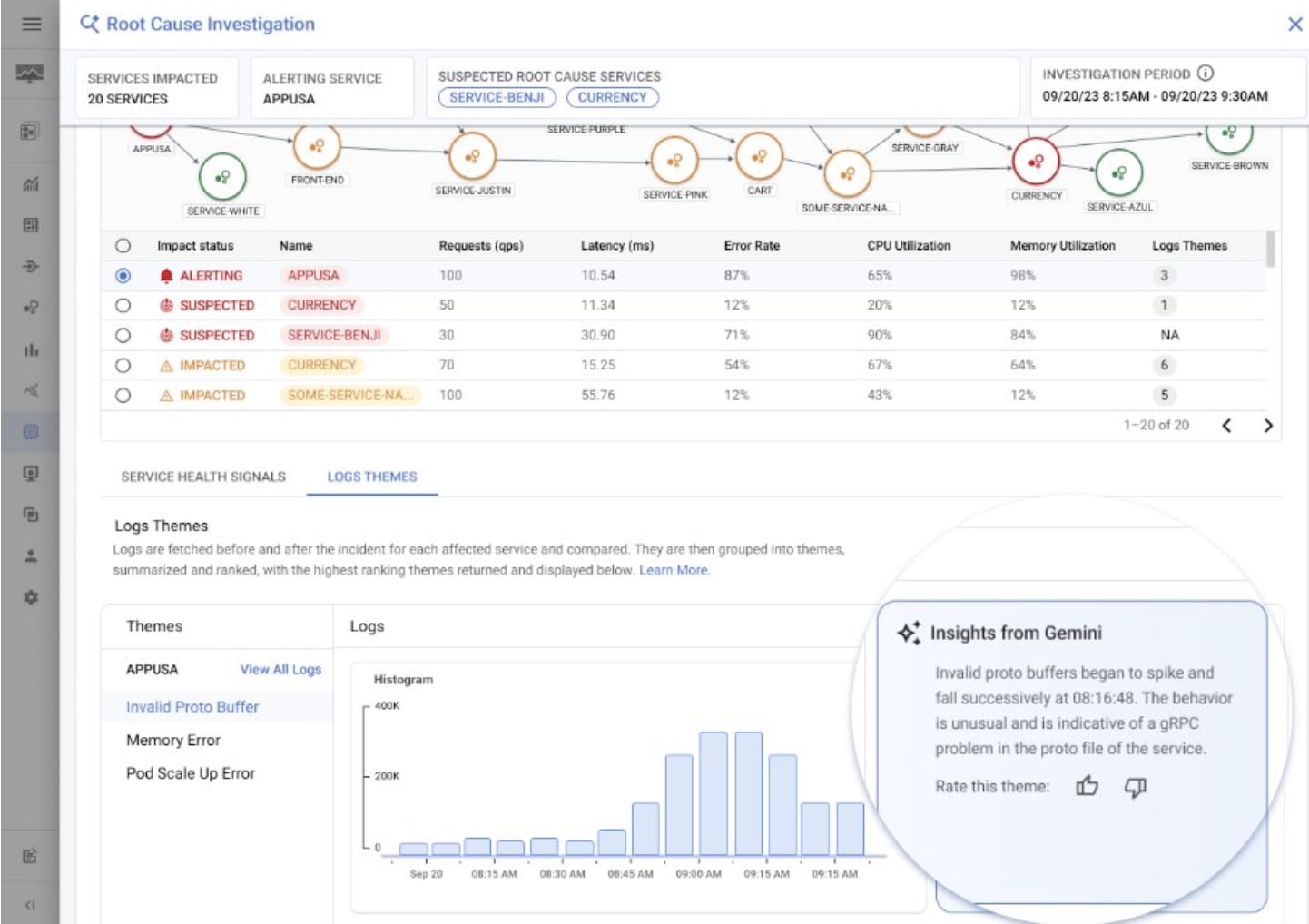

AI:Gemeni Cloud Assist

丁度、Google Cloud Next Tokyo'24 基調講演で発表された新機能。(Ubie では Private Preview として以前から利用していた) 今後、Gemeni を Cloud Console に統合し、AI と対話形式でアラートやトラブルシューティング時に役立つ機能を提供することを期待している。

まとめ

- Cloud Monitoring:

- アラートやダッシュボードの作成だけでなく、SLO を使った実践的なモニタリングができる

- GMP:

- Prometheus と Cloud Monitoring の双方のメリットを享受しつつ、エンドユーザ固有のメトリクスを収集・可視化することが可能

- Advanced Obersevability:

- Obersevability Analytics により SQL を駆使したログやメトリクスの分析も可能になる

- AI / Platform Engineering:

- Platform Engineering や AI の観点でより開発者が使いやすいプラットフォームの提供を目指している

所感

全体的にクラウドオペレーション周りが非常に整備されている印象でした。

特にマイクロサービスにおけるオブザーバビリティは、組織やプロダクトによって様々な手法があるが、Ubie では Google Cloud のソリューションを適切に活用しつつ、各種 SaaS との連携や、新規プラットフォームツールを最適な形で導入できているなと思いました。

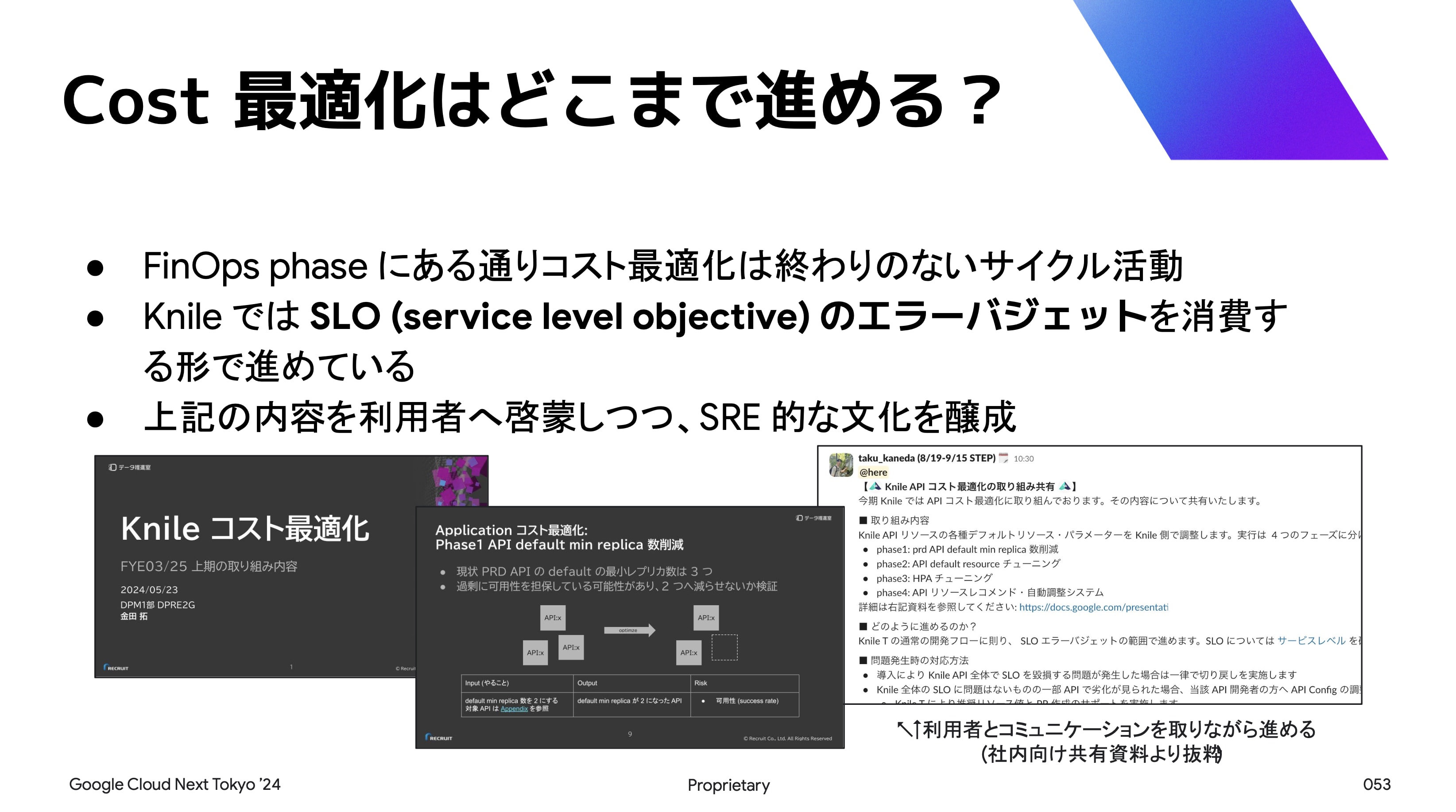

【Day 2】リクルート:FinOps 推進事例

- 8 月 2 日(金)15:00 - 15:30

- https://cloudonair.withgoogle.com/events/next-tokyo-24?talk=d2-inf-02

株式会社リクルート 金田 拓 氏

データ推進室 エンジニア

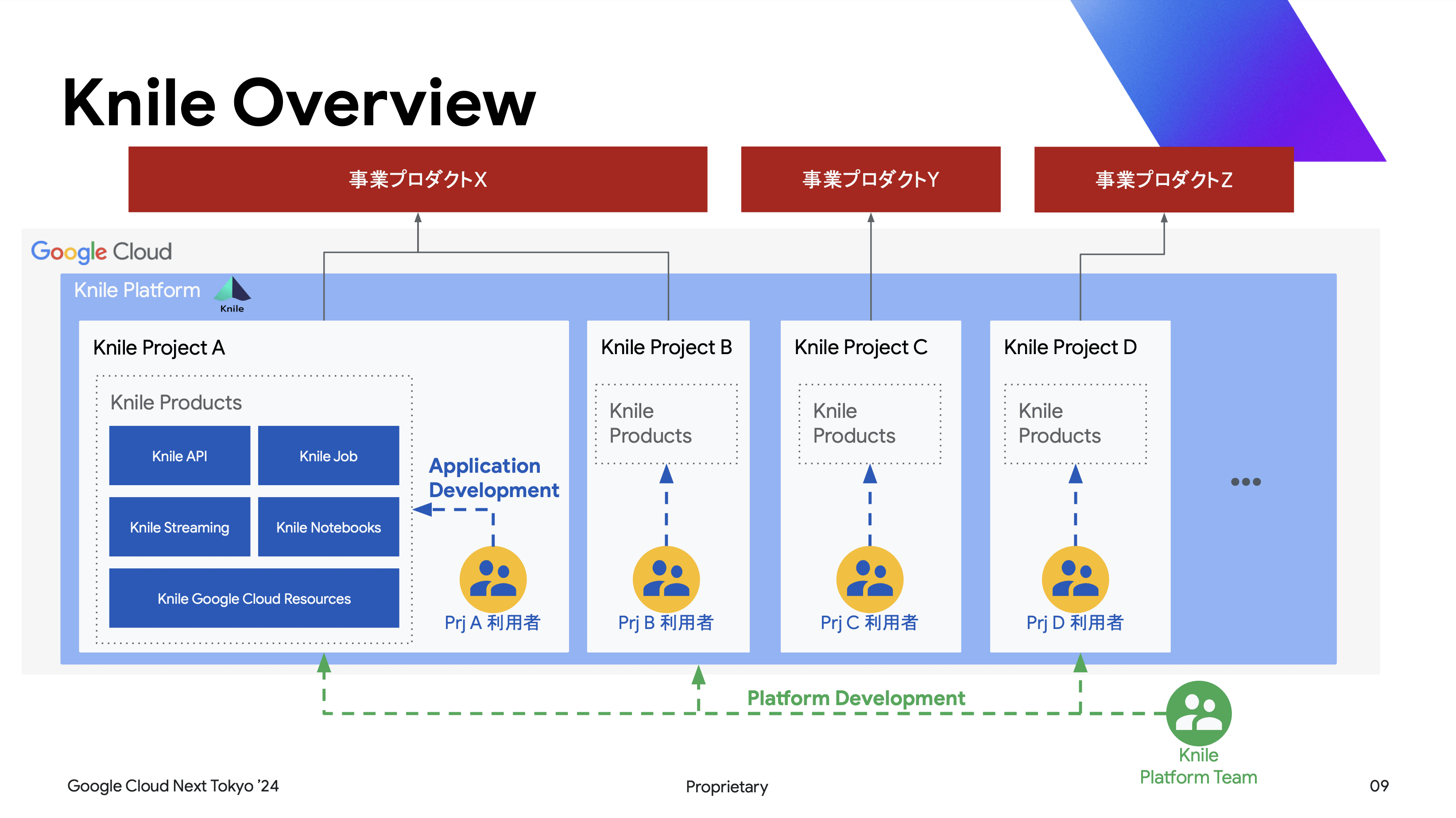

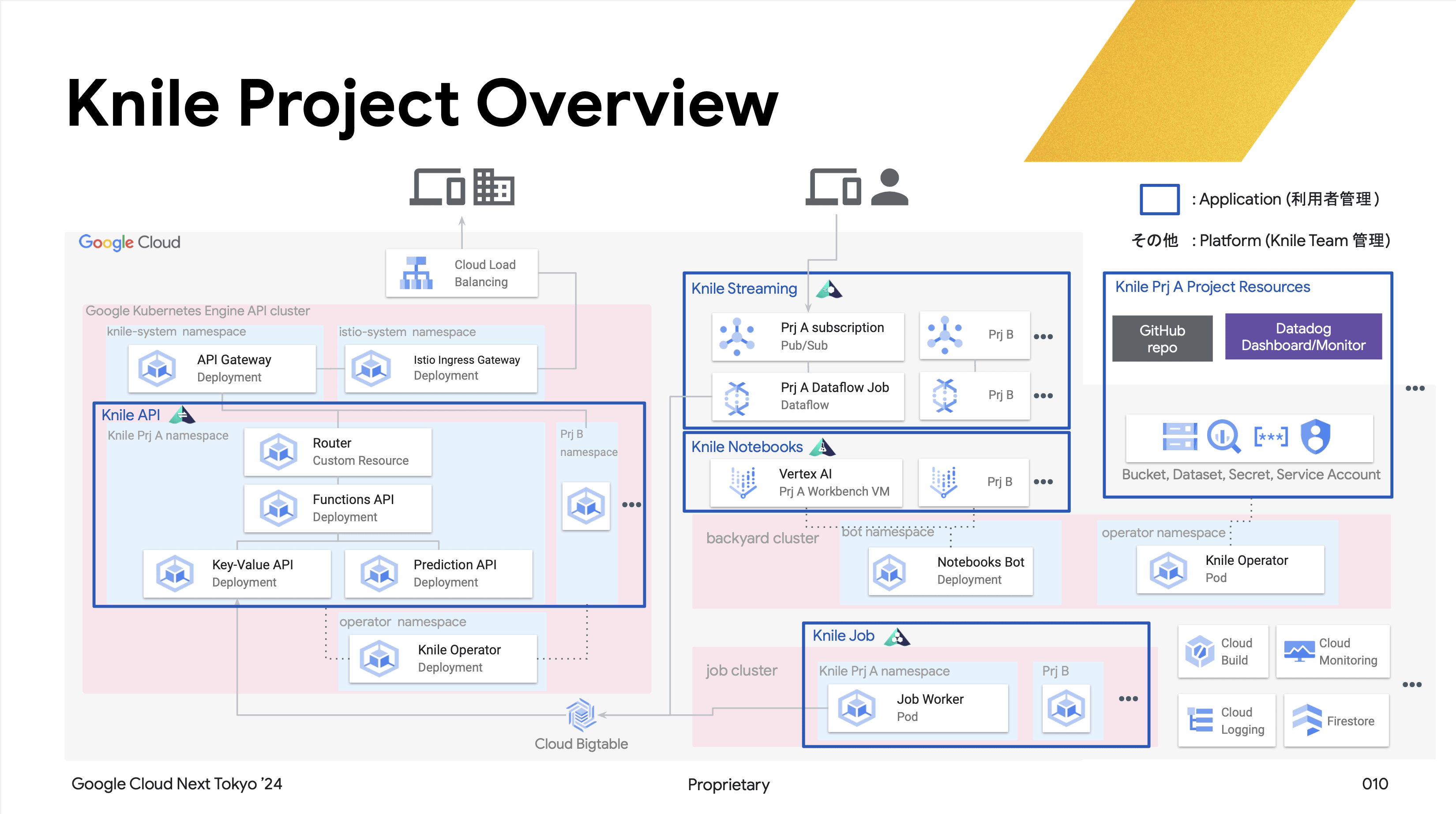

リクルートの IDP「Knile」の FinOps 取り組みを紹介します。Knile は社内の複数案件に対して API や Job 等を提供しているマルチテナント基盤で、GKE をメインに構築されています。近年、利用増加に伴うコスト増化や透明性が課題でしたので、FinOps の導入によるコスト管理と最適化を実施しています。コストの可視化と割り当てを中心に、IDP チームへの実践例を提示します。

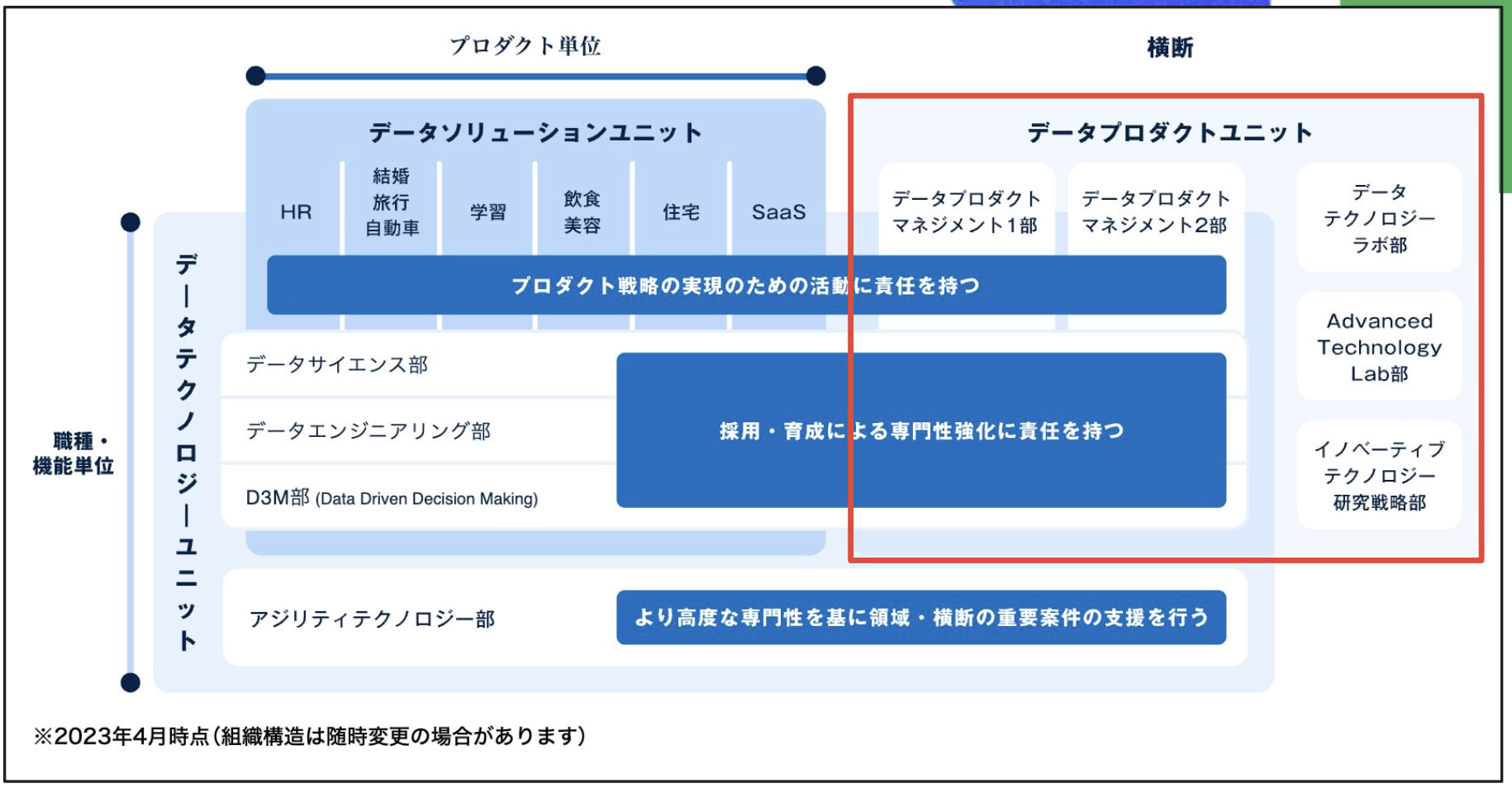

データ推進室における FinOps の導入と実践例

- データ推進室の概要

データ推進室は、マトリクス型組織として構成されており、タテの事業領域特化とヨコの横断の専門職に分かれている。 300 名以上が在籍しており、データサイエンスからデータマネジメントまで幅広い職種が集まっている。 特に、横断組織データプロダクトユニットには多種多様な Internal Developer Platform(IDP)が存在している。

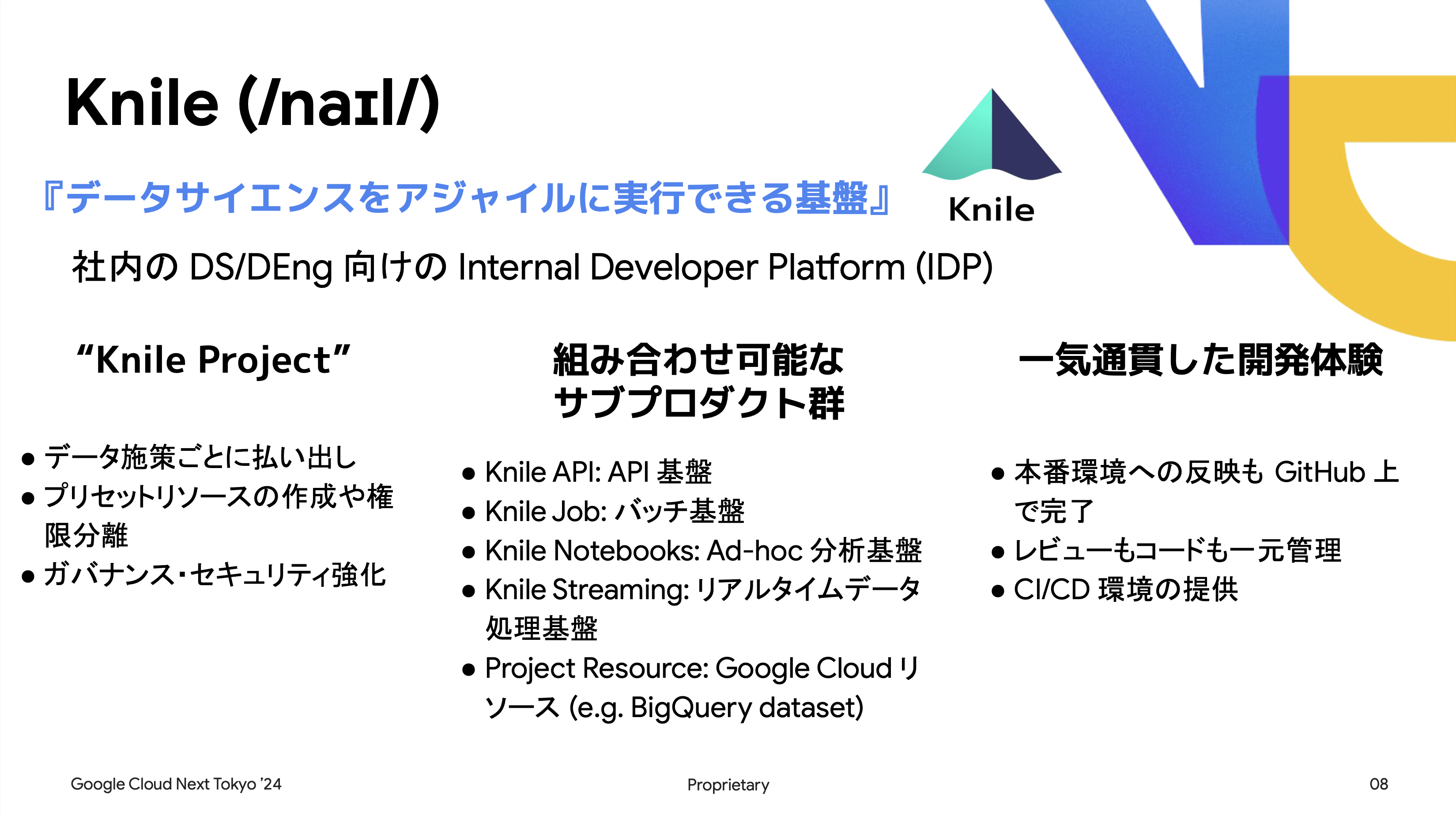

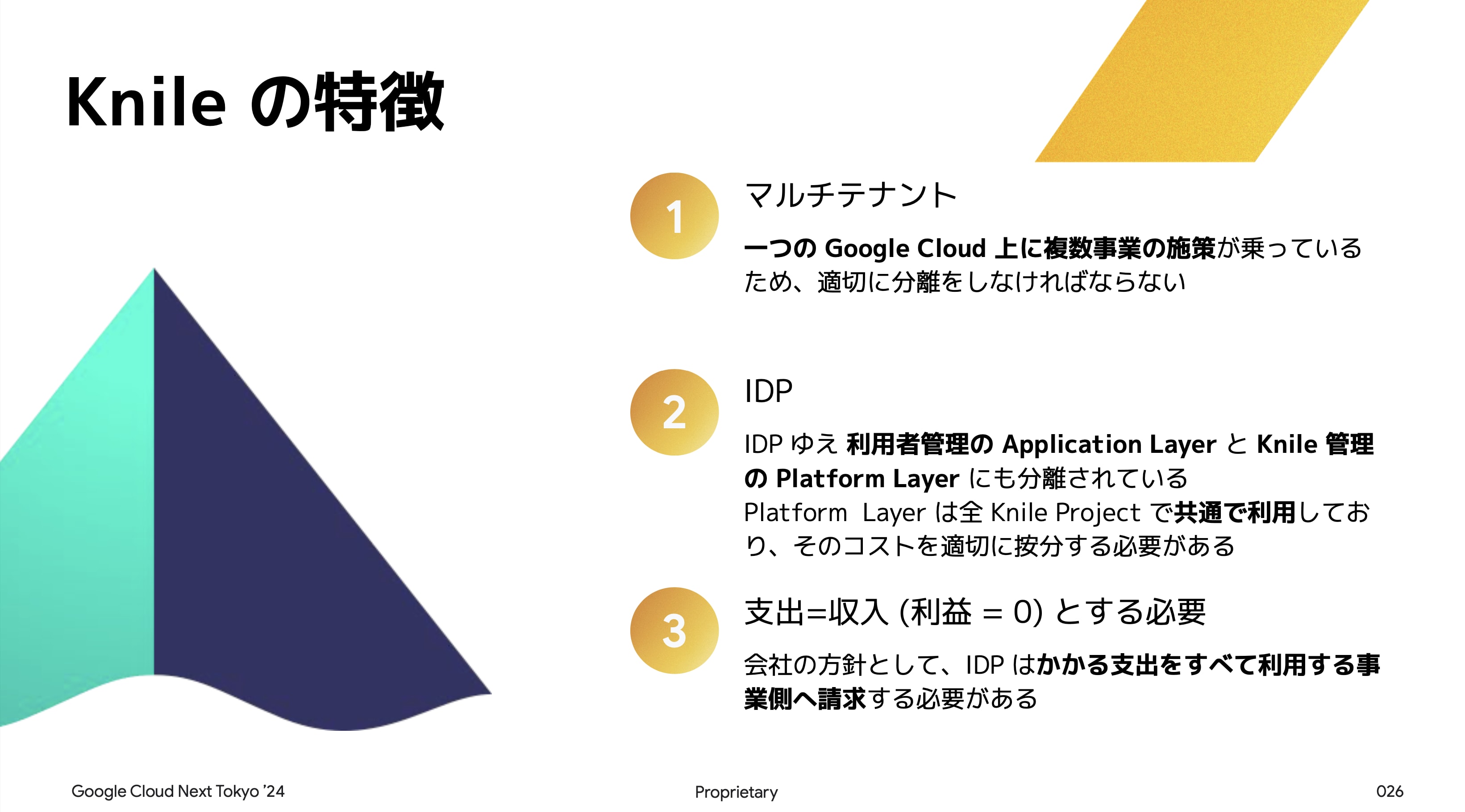

Knile の特徴と役割

Knile は、データサイエンスをアジャイルに実行できる基盤として社内のデータサイエンティストやデータエンジニア向けに提供されている。 Knile Project は、各データ施策毎にプリセットリソースと権限分離の機能を提供し、強固なガバナンスとセキュリティを実現している。

Knile は以下のサブプロダクト群と組み合わせて運用される:

- Knile API:API 基盤

- Knile Job:バッチ基盤

- Knile Notebooks:Ad-hoc 分析基盤

- Knile Streaming:リアルタイムデータ処理基盤

- Project Resource:Google Cloud リソース

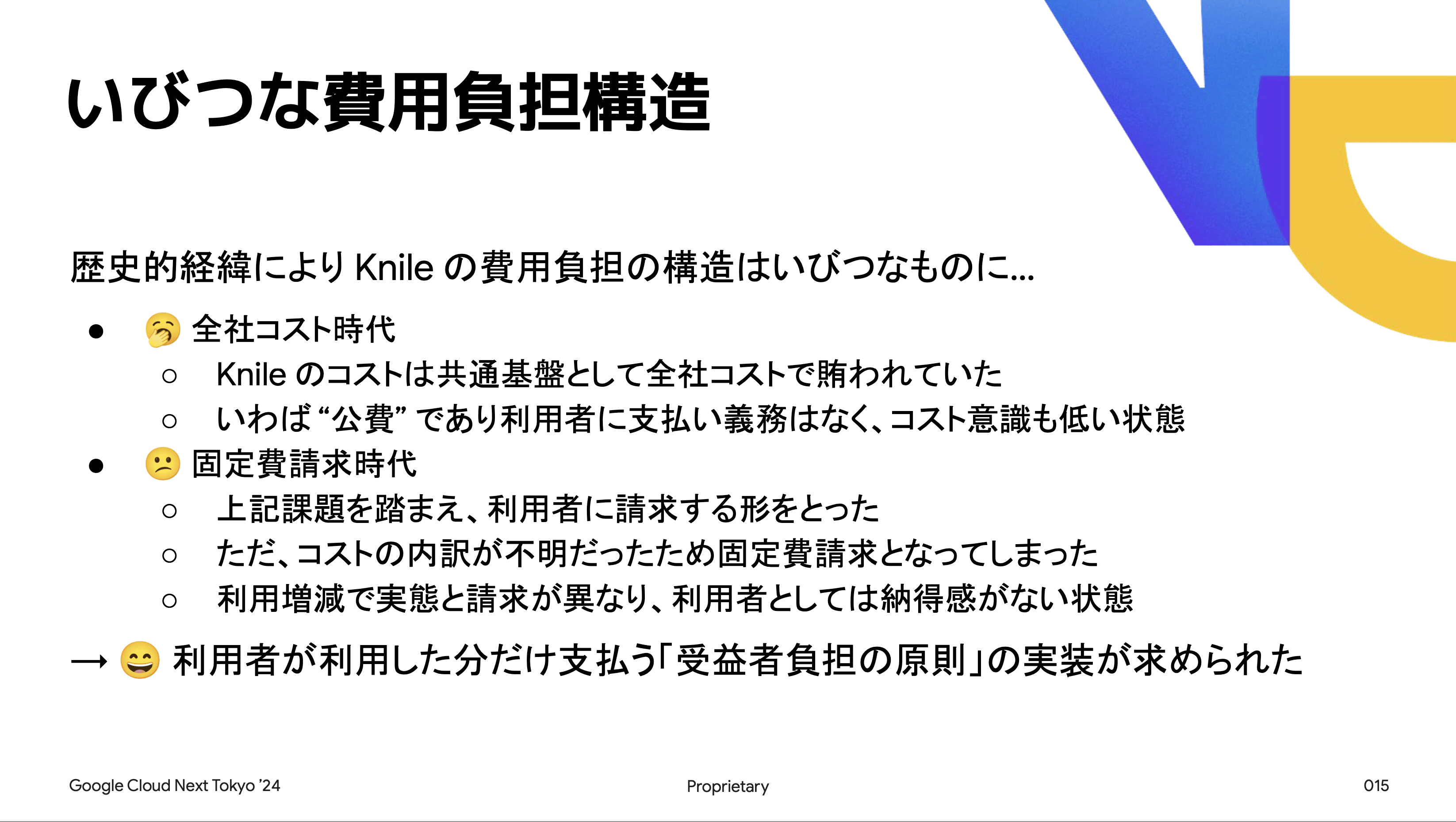

課題

Knile の利用者数が増えるに従って、コストの内訳が不透明になるという問題が生じた。 これにより、各リソース単位や施策単位でのコストが不明確となり、利用者および Knile Team の誰も正確なコストを把握できていなかった。 その結果、歪な費用負担構造へと繋がった。

初めは全社コストとして Knile のコストを賄っていたが、利用者に固定費を請求する形へと移行した。

しかし、利用増減に伴う課金が行われず、利用者としては納得感が低い状態だった。 こうした状況を踏まえ、「受益者負担の原則」を実装する必要があった。

FinOps の導入

FinOps は、クラウドのビジネス価値を最大化し、タイムリーなデータ主導の意思決定を促進するフレームワークと文化的実践。 エンジニアリング、財務、およびビジネスチーム間のコラボレーションを通じて財務上の説明責任を確立する。

- FinOps の目的

FinOps の導入により以下の三点を実現したい:

- 利用者のコスト意識向上

- アクセス可能なデータによる施策

- コスト最適化

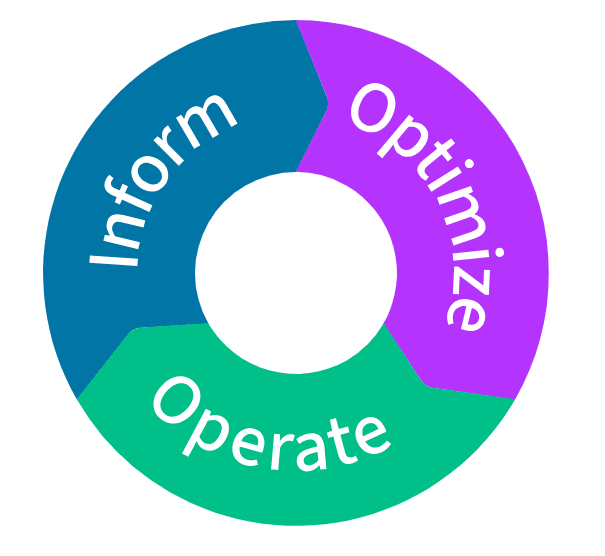

FinOps の 3 つフェーズ

FinOps には以下の 3 つのフェーズが存在する:

- Inform(可視化と割り当て)

- Optimize(最適化の計画)

- Operate(実行と運用)

Knile では最初の Inform フェーズすら十分にできていない状態だった。 そのため、まずは Inform フェーズの整備を行うことが求められた。

FinOps Inform フェーズの導入プロセス

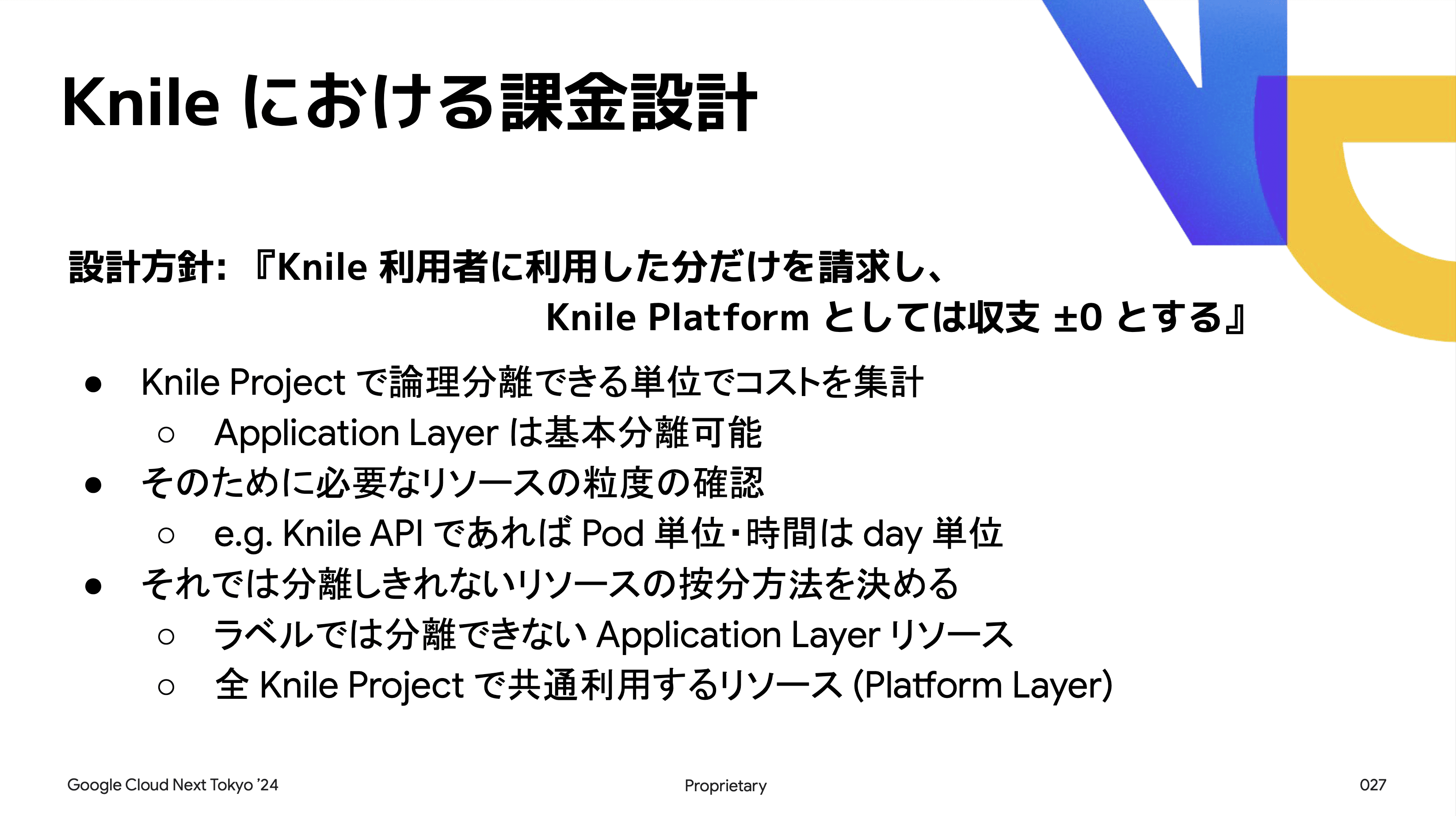

- 設計と実装

プロダクトの課金設計を行い、必要な実装を進める。 Google Cloud のラベルを活用することで、コストの可視化や課金請求の運用業務を行う。 そして、プロダクトの特性や各会社・事業・プロジェクト毎の要件に応じて設計を進める。

- 設計の例:Knile

Knile では以下のような課金設計を採用した:

- Knile 利用者に利用した分だけを請求し、「収支 ± 0」とする

- Knile Project で論理分離できる単位でコストを集計

- ラベルや GKE Usage Metering を活用してリソースを分類

※ GKE Usage Metering とは GKE においてリソースの使用量および割り当て量を Kubernetes のラベルを元に分析をするための機能です。 ラベル情報からリソースの割り当て先やコストの概算値を算出することが可能となります。

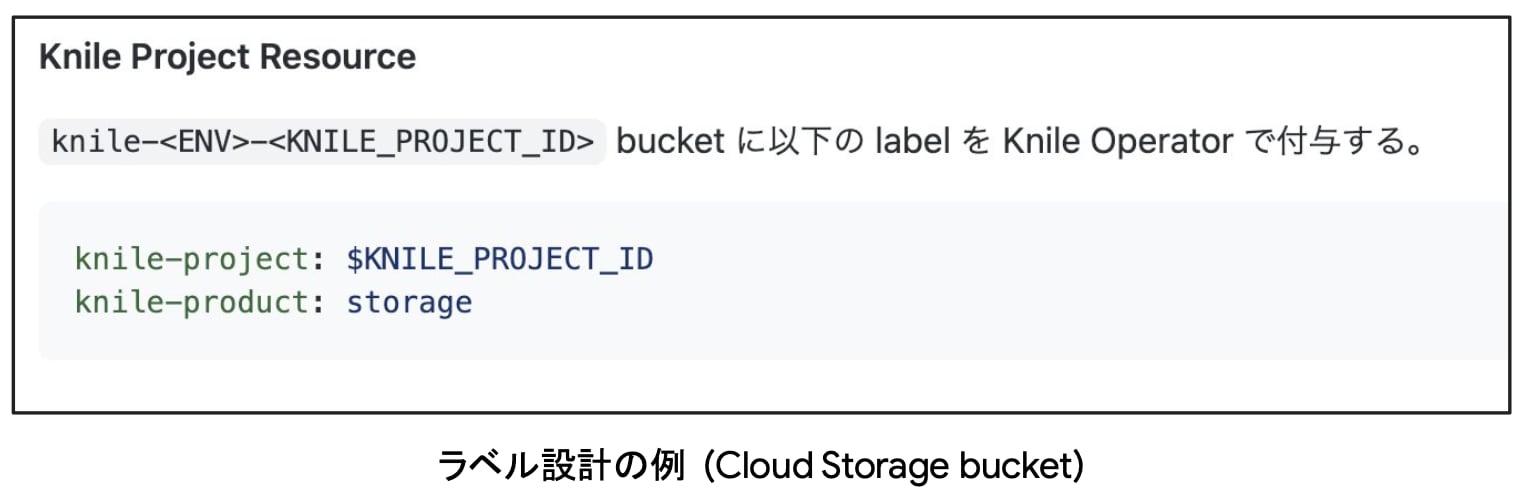

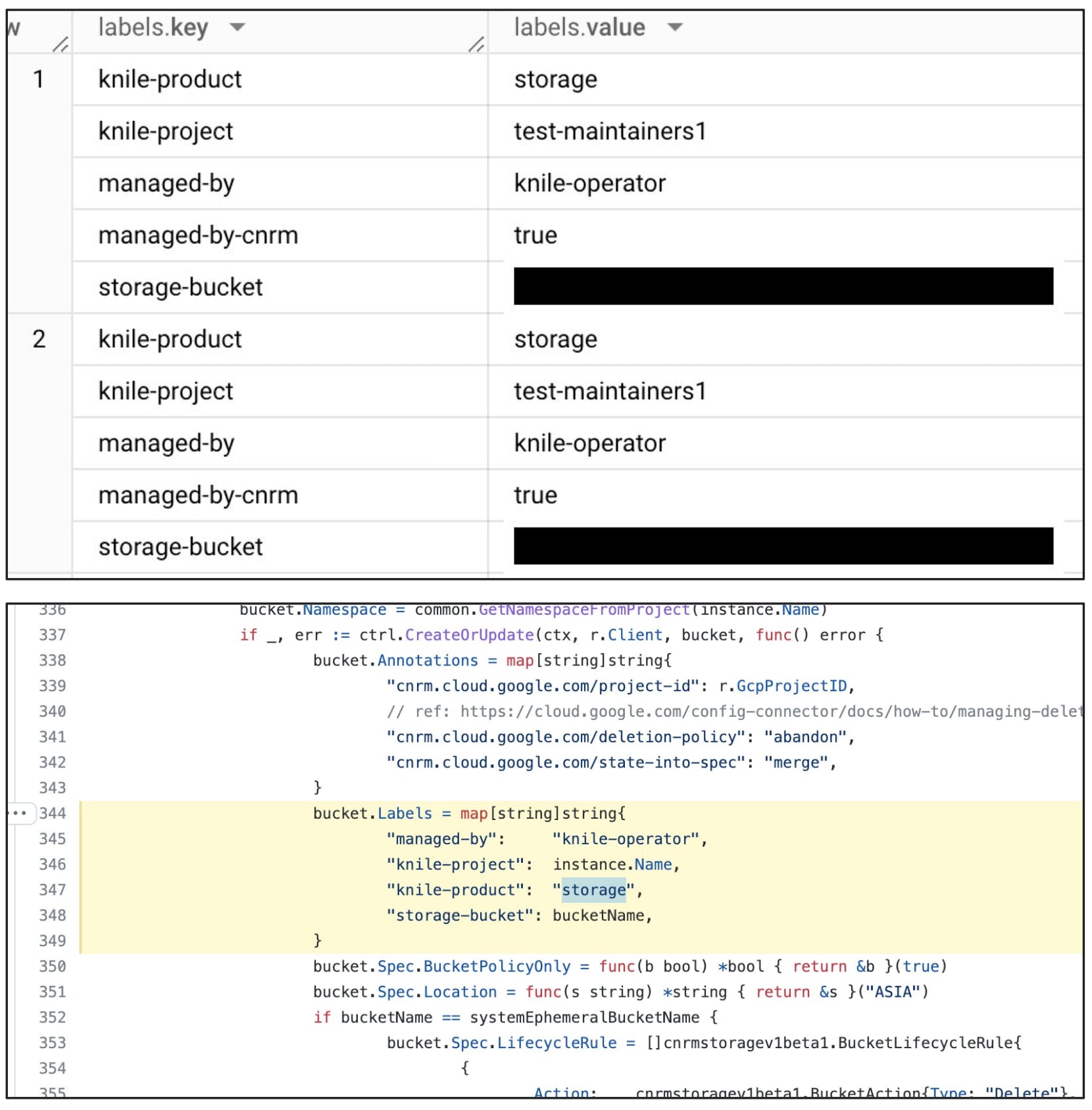

実装詳細

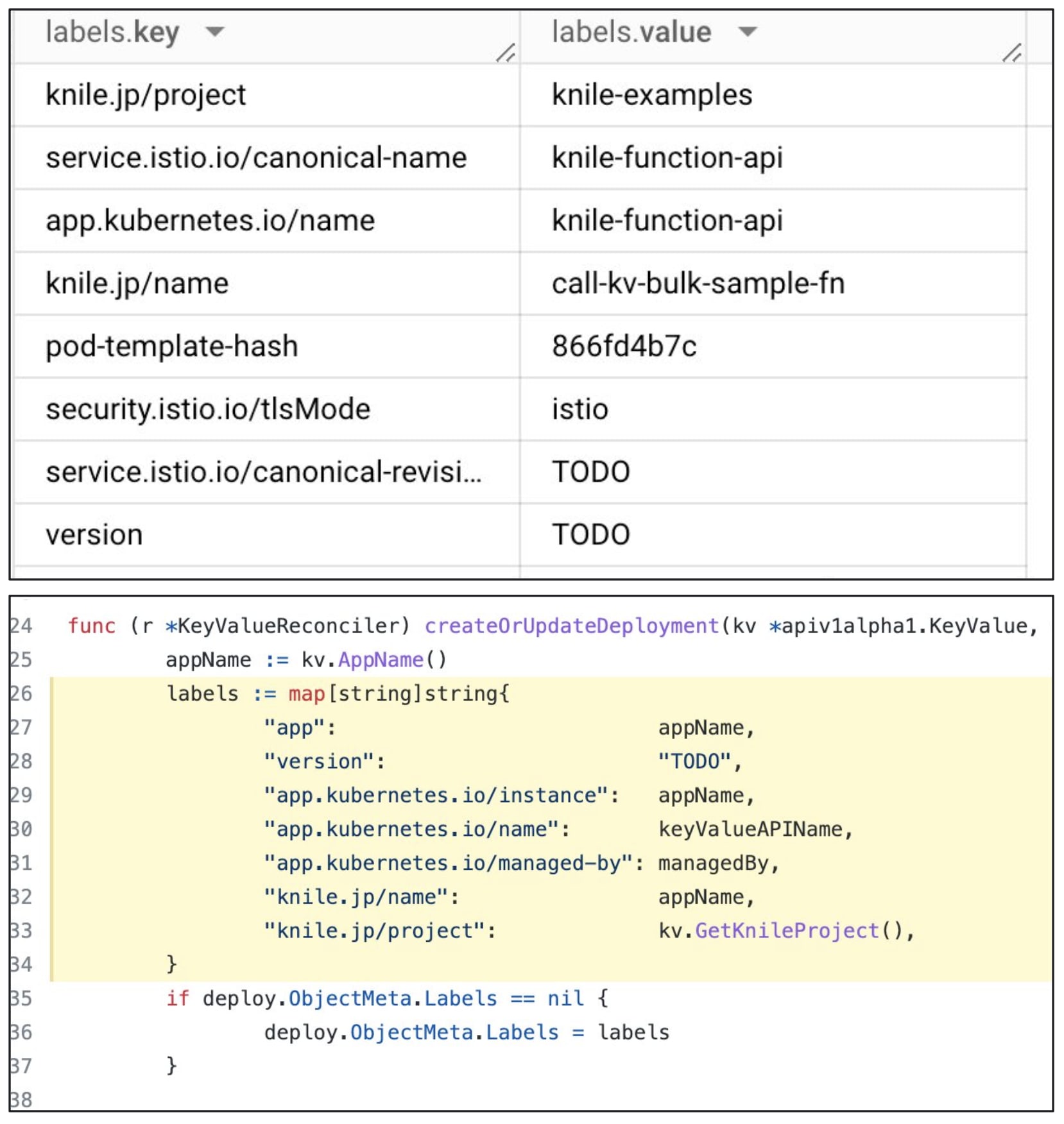

- リソースラベル

Google Cloud の各種プロダクトはラベルによってコストの分類が可能となっている。 このラベルを用いることで Knile Project の論理分離粒度でコストを集計する。 また、ラベルの設計・設定はコードで管理する。

- GKE Usage Metering

GKE ではクラスタリソースのデータを BigQuery に連携可能で、これを使ってコストを算出する。 Knile では主に Knile API のコスト集計で使用している。

カスタムコントローラの場合、任意のラベルをマニフェストで付与することができないため、直接コントローラのコードに埋め込んでいるよう。

- ラベルで分類できない場合

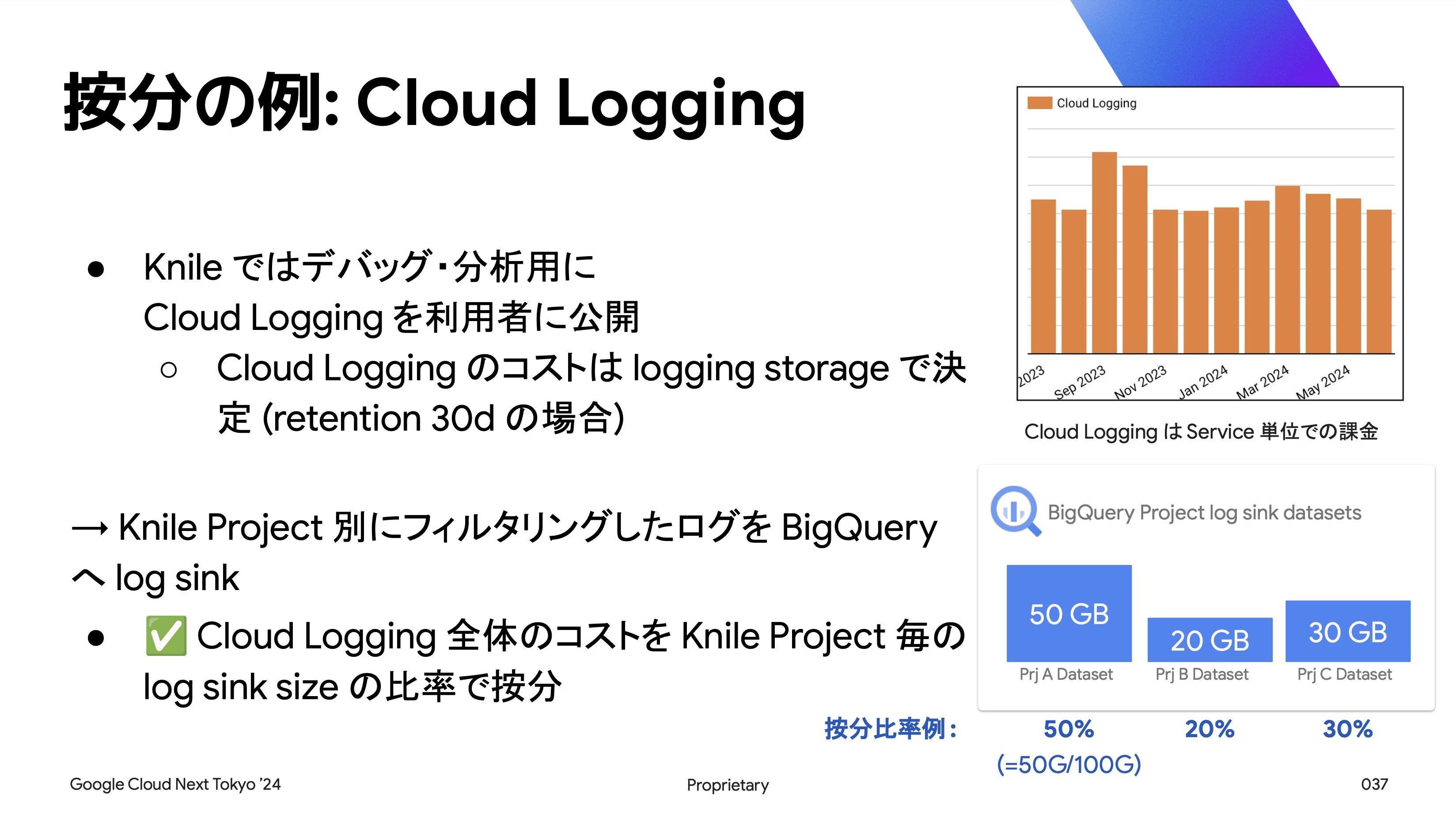

いくつかの Google Cloud リソースはラベルで Knile Project の論理単位で分類できない場合がある。(例:Cloud Logging) しかし、適切にコストを按分する必要があるため、リソース毎に按分ロジックを取り決める。

Cloud Logging のコストはログストレージで決定されるため、Knile Project 毎にフィルタリングしたログを BigQuery へ log sink し、その比率で按分する。

- 共通費の按分

Knile には全 Knile Project で共通利用のコンポーネントが複数存在する。 こうしたリソースの按分方法も考慮に入れ、Knile では「Application Layer の利用金額比率」で按分している。

実装のまとめ

- 各 Knile Project 毎に按分されたデータをまとめて一つの BigQuery テーブルとし、Google Cloud のリソース分類機能や GKE Usage Metering を活用する

- また、共通費は Application の金額割合で按分する

FinOps Inform Phase 導入プロセス

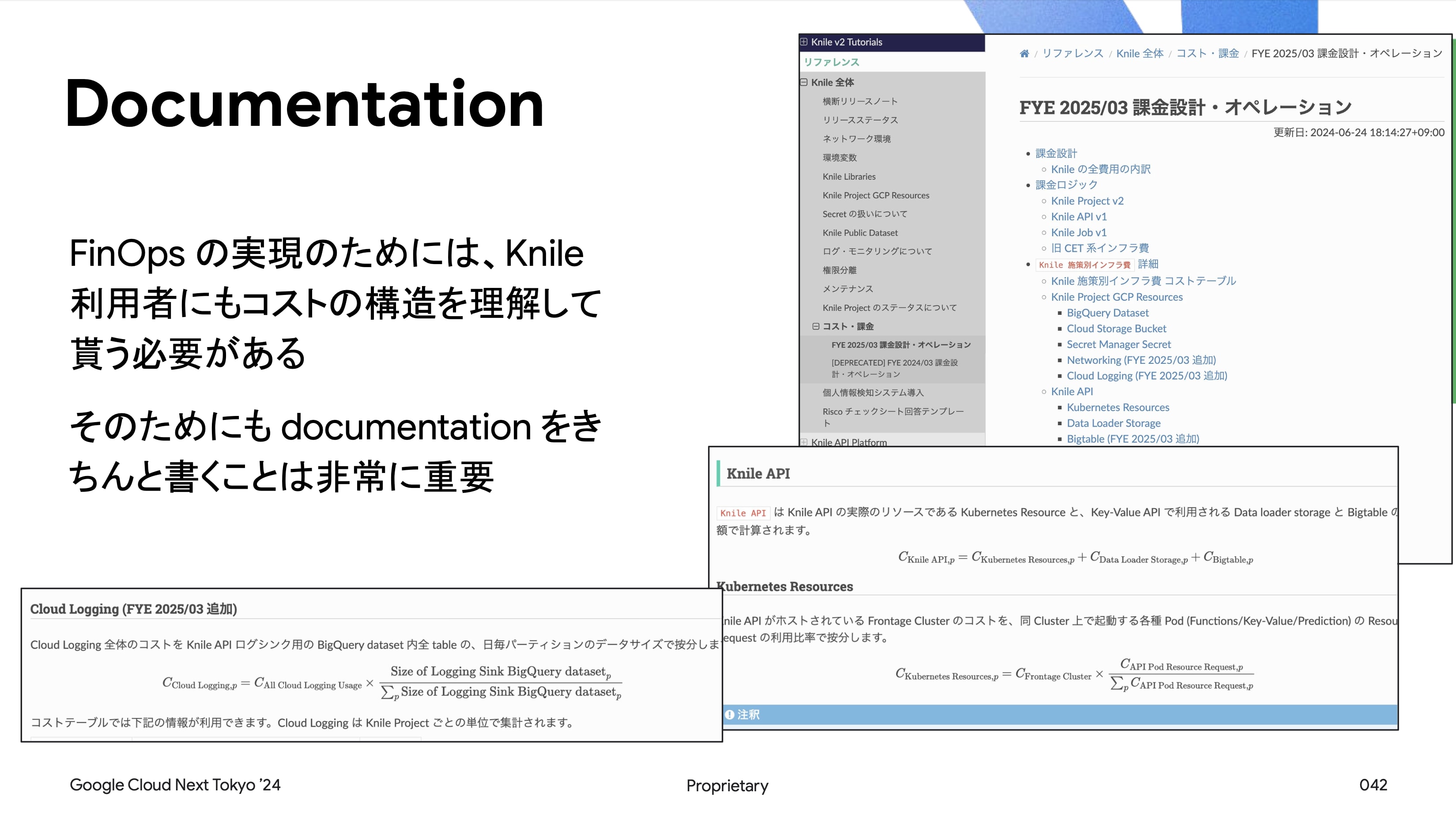

- Documentation と可視化とその重要性

FinOps を実現するためには、Knile 利用者にもコストの構造を理解してもらう必要がある。 そのため、ドキュメントをきちんと作成することが重要である。

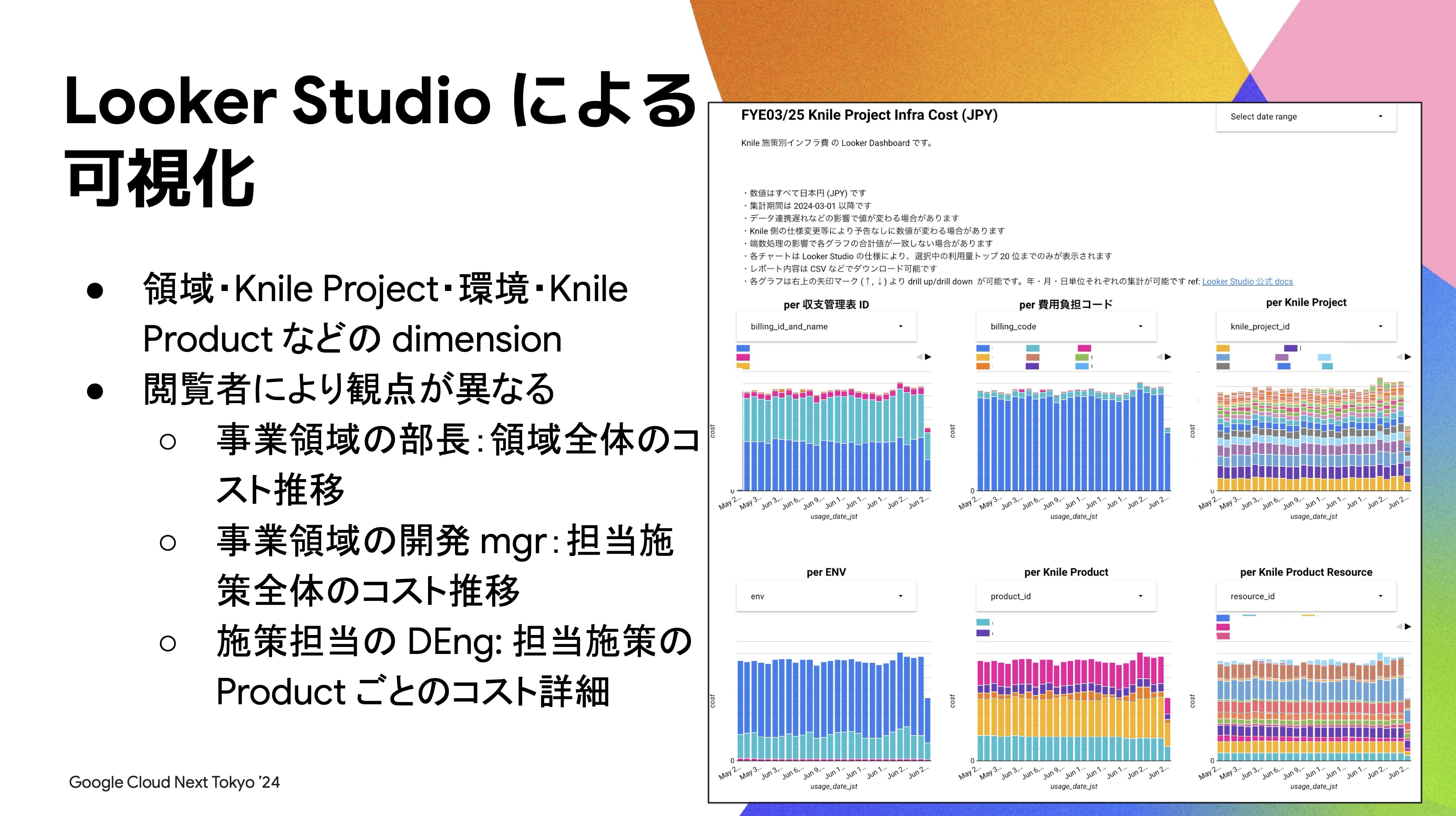

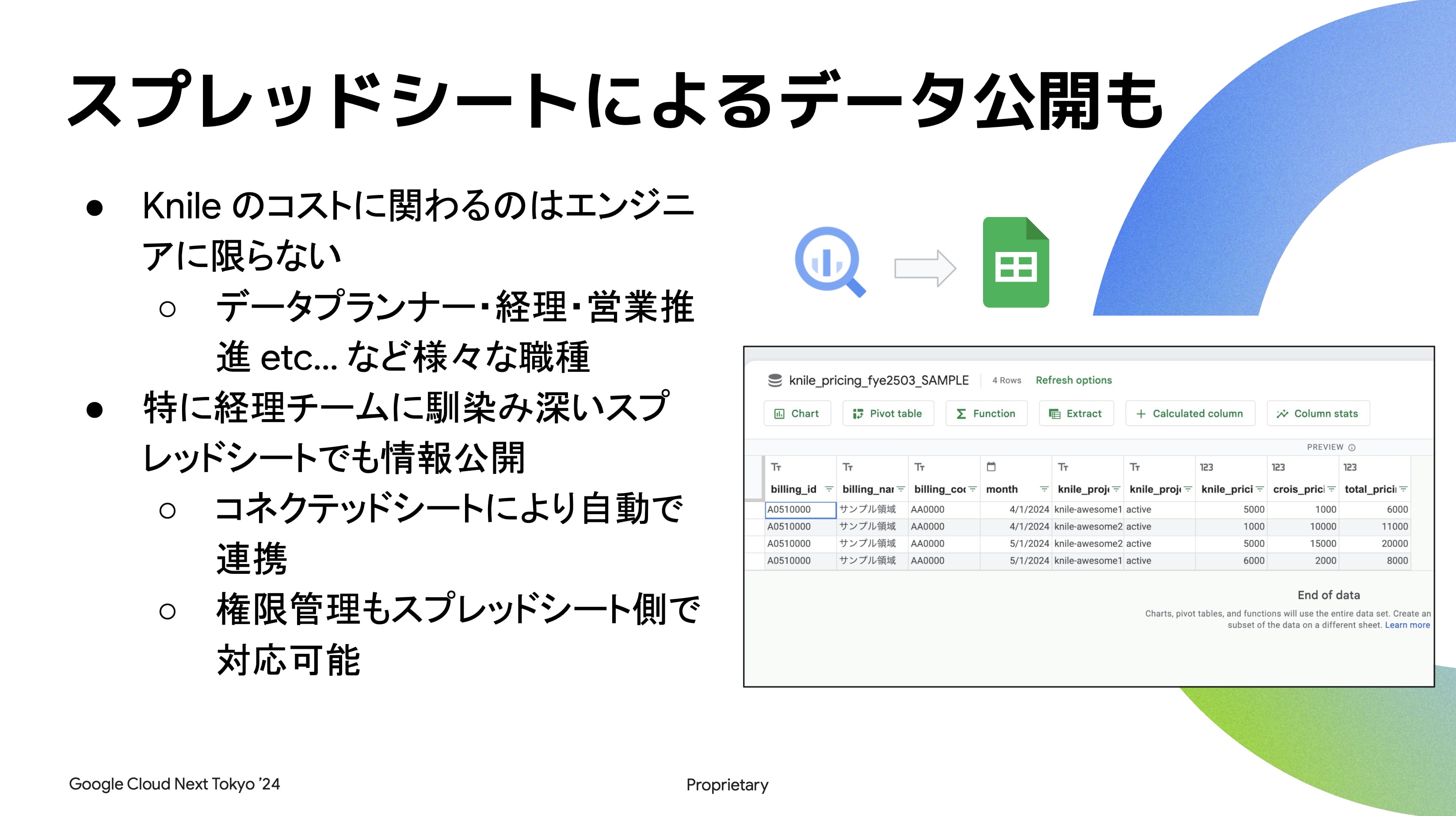

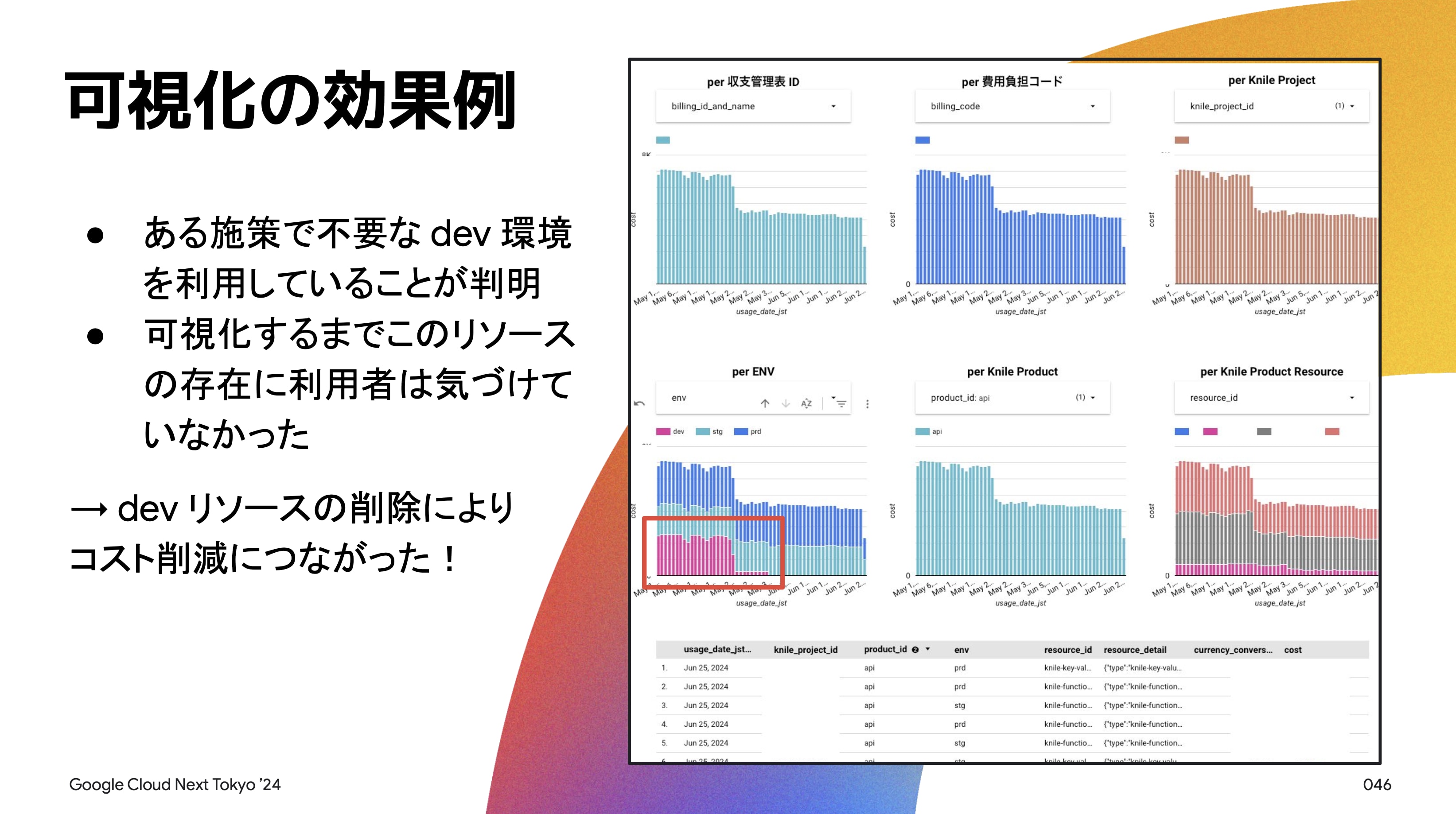

- Loogker Studio による可視化

Loogker Studio を用いて、領域、Knile Project、環境、Knile Product 等の dimension でコストを可視化する。 この可視化により、各利用者が自分が関与する施策のコストを具体的に把握できるようになる。

- 可視化の効果例

可視化の例として、ある施策で不要な dev 環境が確認され、コスト削減に繋がった事例がある。

Knile の現在地と今後の取り組み

- 現在の状況

Inform フェーズは整備され、各コストの責務分離も実現できている。 次のステップとして Optimize と Operate に取り組む予定である。

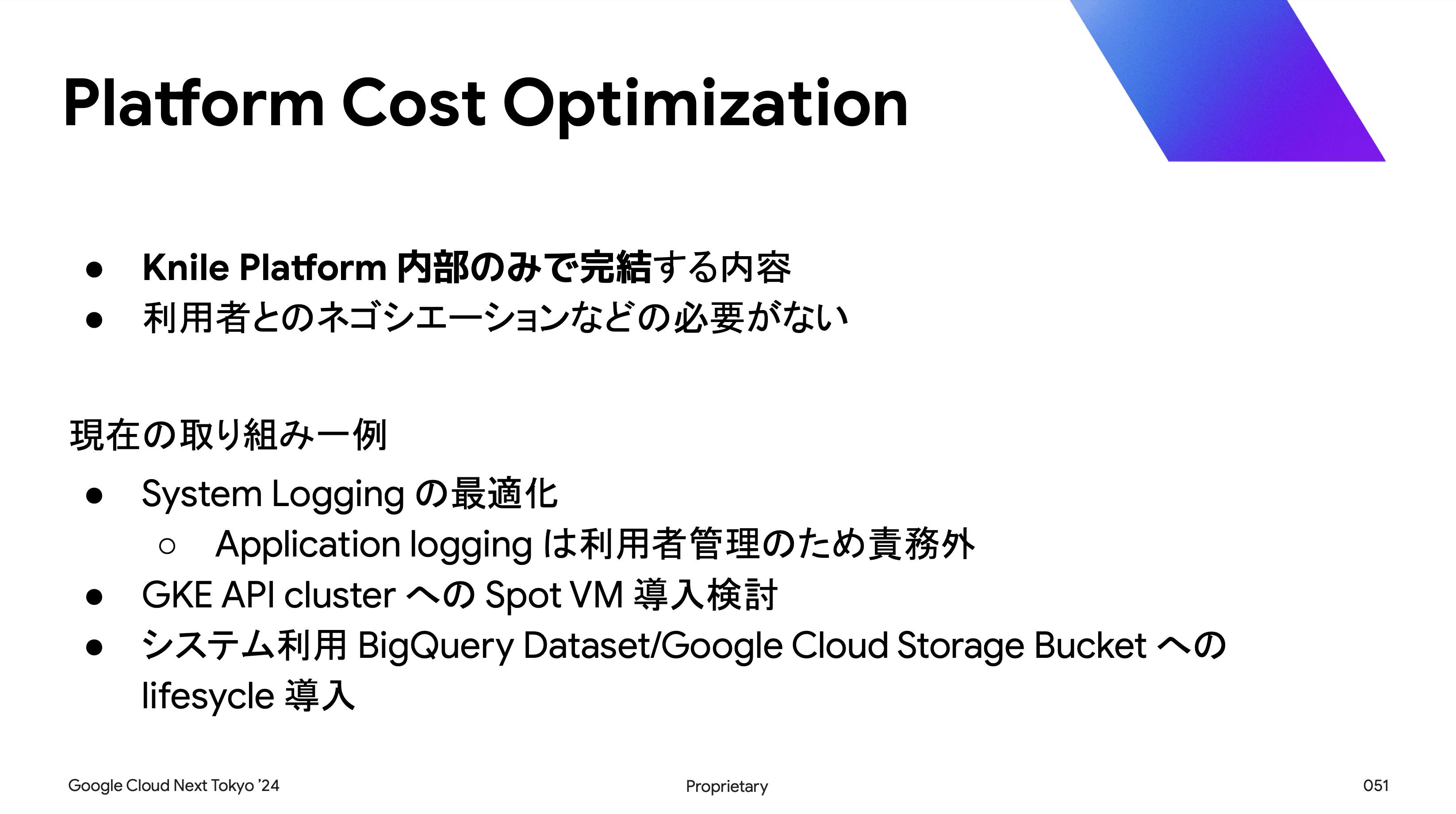

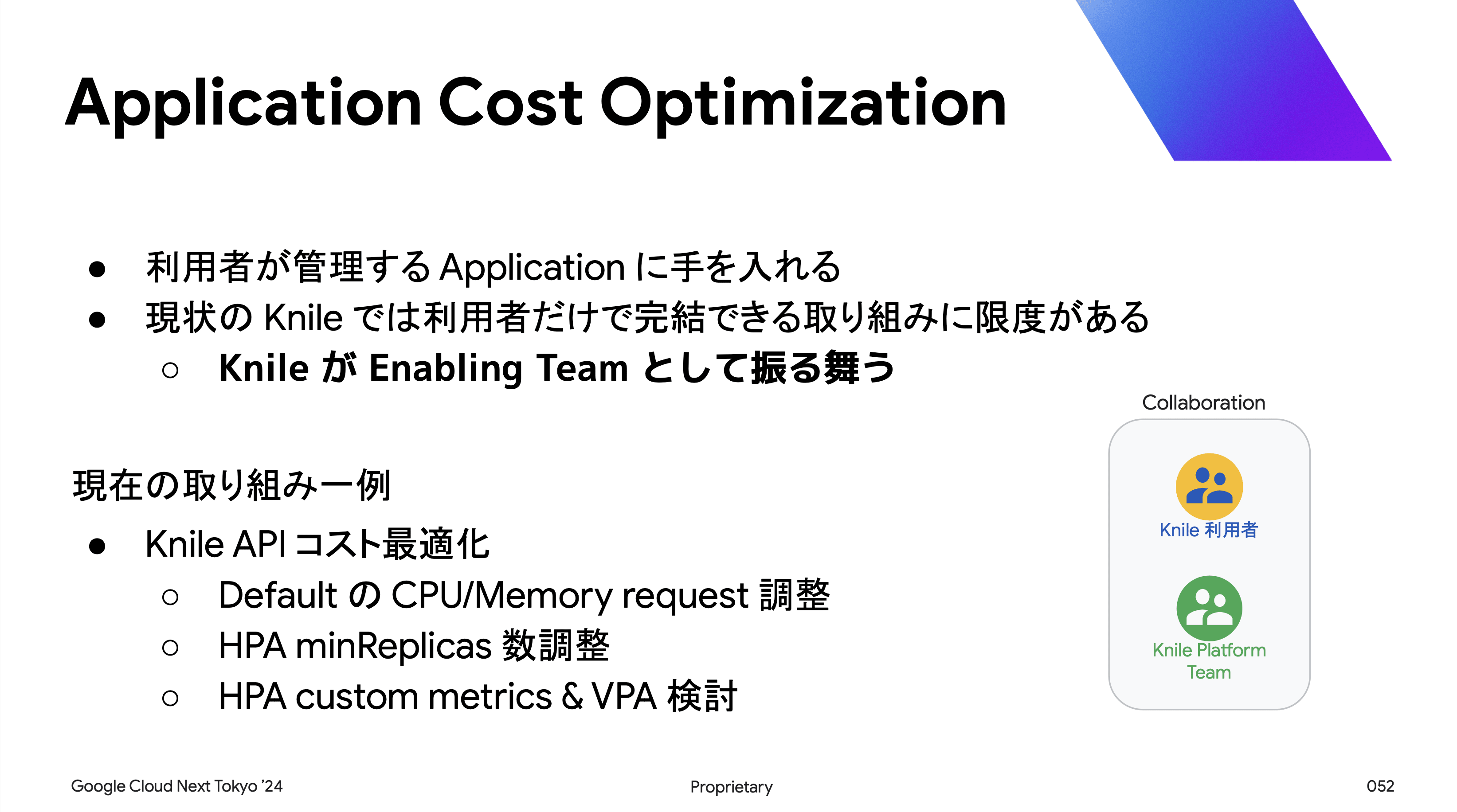

- 今後の取り組み

コスト最適化の取り組みとして、Platform Cost Optimization と Application Cost Optimization を行う。 Platform 内部で完結する内容や、利用者だけで完結できない内容については Knile が Enabling Team としてアプローチする。

最終目標

FinOps のフェーズに沿い、IDP では Platform と Application に責務を分類して、それぞれに対してのアプローチを進める。 コスト最適化は終わりのないプロセスであり、Knile では SRE 的な文化を醸成しつつ進める。

まとめ

- 要件・制約の確認:

- FinOps もいち Feature

- 要件は会社・部署・プロジェクト等により様々

- IDP & マルチテナントの場合は複数の部署との交渉も

- まずは計測から:

- 設計を元にコスト集計の実装を進める

- BI ツールを使い可視化

- データは誰でもアクセスできるように

- 最適化を始めよう:

- 計測により最適化ができる部分が見えてくる

- IDP では Platform と Application に責務分類

- それぞれ Platform / Enabling Team としてアプローチ

Ask the Speaker にて質問

セッションを聞いていていくつか疑問点が出てきたので、直接、金田氏に質問してみました。

BigQuery に対する Job スケジューラによって得られたコスト値の妥当性はどのように担保している? 例えば、GKE Usage Metering によって収集されたコストは、Cloud Billing で正確に確認することはできない。

- GKE Usage Metering は費用をプロジェクト単位に按分するための指標としてしか使用していない

- GKE ワークロードにおいて、どのコンポーネントにいくら掛かっているかまでは現段階では詳細に取得していない

- ノードやディスク(Core / Ram / PD)に対する費用だけであれば、ラベルの仕組みと Cloud Billing を以て妥当性を検証可能なので、Knile としてはそこまでの要件が出てきていない

GKE Usage Metering は Deprecated となるが、代替え案は考えている?

- GKE Usage Metering が非推奨 になるのは知らなかった

- GKE Usage Metering はあくまでもコスト按分のおおまかな指標としか使用していない

- (2024 年 8 月時点で、ABEMA では Structure of Detailed data export + GKE Cost Allocation に移行したので、他社事例を知りたかった)

BigQuery で一元管理しているコストデータは、FinOps Phase における Optimize, Operate において、どのように利活用している?

- スプレッドシートに連携してビジネスサイドライクな形式をとっている

- FinOps では、如何に組織の人間がその仕組みや最適化の重要性について理解しているかが重要

- Grafana をはじめとする他のモニタリングツールには現状連携していない

所感

FinOps と一言で言ってもアプローチの仕方や取り組みは組織によってまちまちだと思います。 私は直近、ABEMA 開発組織の Cloud Platform Team(いわゆる IDP)にて、FinOps を推し進めようとしていたため、リクルートの事例が気になって本セッションを聴講しました。

特に、Inform Phase 以降は、組織としての FinOps に対する理解を強める必要があると強く感じました。 実際に多くの開発組織において、可視化ができているが、最適化まで完璧に熟しているという事例はあまり耳にしません。 Optimize / Operate フェーズを進めたり、FinOps 文化をより強く浸透させるためにも、ドキュメントの整備や各種 BI ツール(如何にしてコスト最適化の仕組みを認知させるか)の活用も非常に重要になってくると感じました。

展示ブース

いくつか展示ブースにもよって見たので紹介したいと思います。

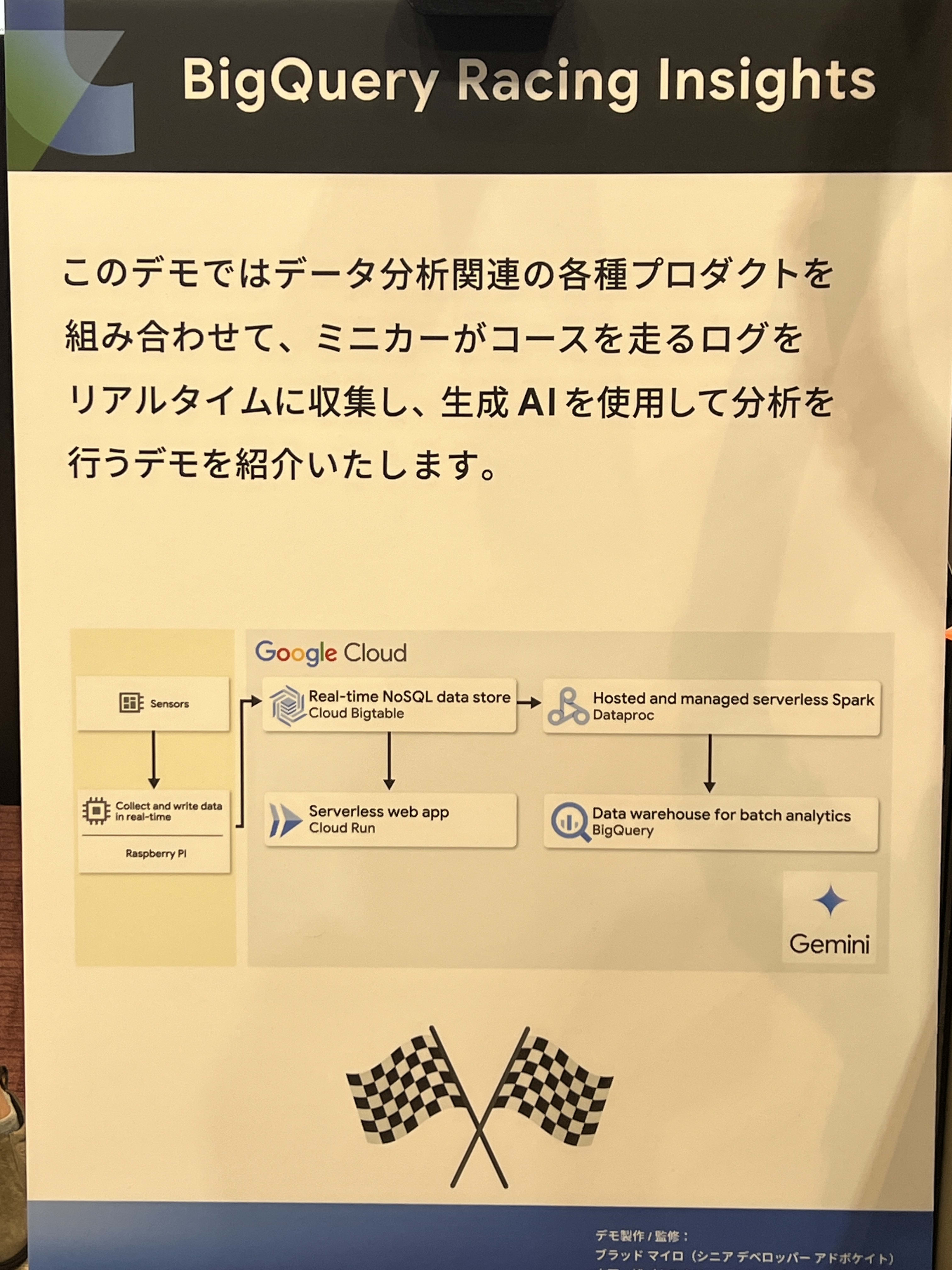

BigQuery Racing Insights

こちらは、Google が提供していたブースですが、ミニカーの走行ログをセンサで収集して、Google Cloud Bigtable に流し、それを BigQuery からクエリできるようにしたシステムです。

- ミニカーが走行した時センサログデータをローカルネットワークから Google Cloud にアップロードして処理

- Bigtable にデータを流して、Spark から新言語処理で任意のデータを取得

- BigQuery からクエリ(Gemini 統合)

非常に短時間に収集される多くのデータを Bigtable にライトし、クエリをかけることでリアルタイムなデータ分析が可能になっていました。

まとめ

とりあえず暑すぎました...🥵

2 日間通して新たに生成 AI 関連の知見を増やすことができました。 Google Cloud はここ数年で急激に AI をプラットフォームツールに導入し、日本企業の多くも、その恩恵に授かりつつ活用事例が増えてきています。 今回、AI エージェントは特に注目を集めているトピックの一つだと思いますが、今後、データサイエンスや ML エンジニアでなくても、AI エージェントを活用することで、AI の価値を存分に引き出すことができるのではないかと思います。 僕自身まだまだ AI に関する知識は浅いですが、引き続き情報のキャッチアップに努め、活用していきたいと思います。

その他、自分の興味のある領域のセッションにいくつか参加をしてみましたが、他社の事例を聞いたり、時には失敗談も聴くことができたりして非常に知見が広がりました。 来年の Google Cloud Next にも参加をしたいし、いずれ自分が登壇できるように今後も技術力を磨きたいと、モチベーションアップにもなりました!

最後に!

久しぶりの横浜だったので、吉村家直系の 杉田家 にも行ってきました 🍜

リピート不可避な味でした 😋😋

弟子が道端で麺上げの修行をさせられていた場所も忘れずに!

【昔の吉村家切り抜き】地獄の修行 1999 〜鞭編〜:

https://www.youtube.com/watch?v=SeIQcAk2eHs

2 日間満喫しきりました 👋